Von der Banalität der Banalität des Bösen

Als Hannah Arendt den Prozess gegen Adolf Eichmann beobachtete, prägte sie den Begriff der Banalität des Bösen, die erschreckende Einsicht, dass Menschen gelegentlich die schlimmsten Grausamkeiten aus Motiven begehen, wie sie uns auch im Alltag bewegen. Bei Eichmann, der damals die Tragödie eines einfachen Beamten aufführte, der sozusagen in Ausprägung von Sekundärtugenden die fabrikmäßige Vernichtung von Millionen von Menschen organisiert hat, war das zwar Quatsch. Er war, weitab von Alltagsrassissmus, ein rabiater, von glühendem Antisemitismus angetriebener Faschist (vgl. die Sassen-Interviews). Die Banalität des Bösen ist dennoch sehr real, wenn auch glücklicherweise in Ligen weit unterhalb industriellen Massenmords.

Ein überraschend deutliches Beispiel dafür findet sich in der taz von diesem Wochenende: Ein Interview mit Wolfgang Schäuble, in dem dieser Einiges über die Beweggründe seiner schrecklichen Politiken verrät. Lasst mich zwei Datenpunkte zum Beleg seiner scheinbar gewissenlosen, autoritären Schurkigkeit beibringen.

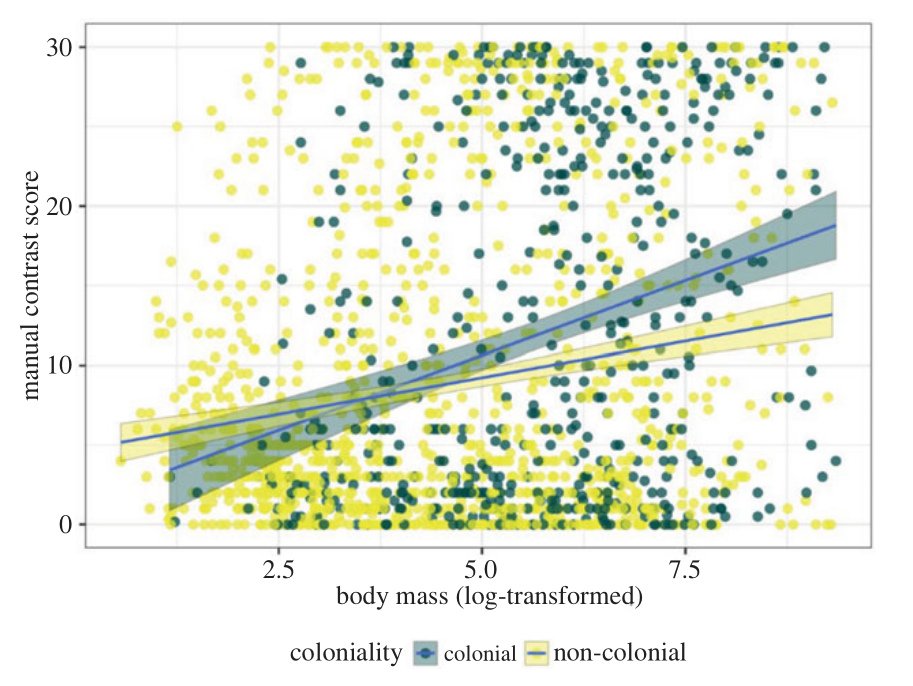

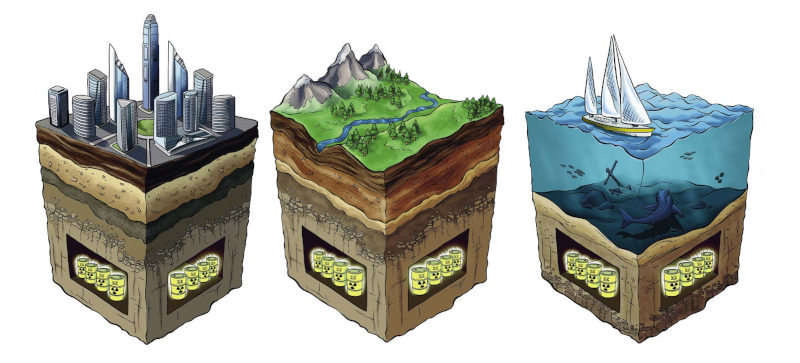

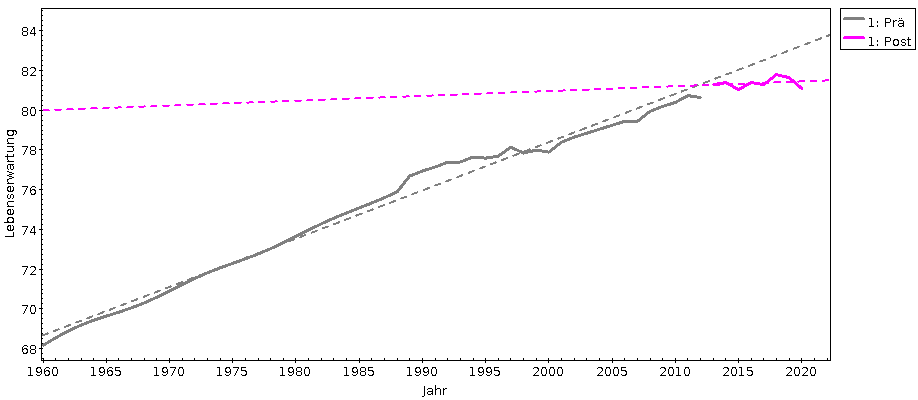

(1) Als Finanzminister (2009-2013) hat er nach der Lehman Brothers-Bankenkrise wesentlich den Einriss des (bereits zuvor eher rudimentären) griechischen Sozialstaats orchestriert (Troika-Politik); ein wenig davon lässt sich im DLF-Hintergrund Politik vom 16.8.2018 nachlesen. Auch für erklärte Metriken-SkeptikerInnen wie mich eindrücklich ist in diesem Zusammenhang die Entwicklung der Lebenserwartung in Griechenland nach Weltbank-Daten. Aufgeteilt in die Zeit vor (Prä) und nach (Post) dem großen Schäuble-Sozialabbau in Griechenland und mit linearen Fits der Entwicklung vor (bis 2011) und nach dem Greifen der Troika-Maßnahmen (ab 2012) sieht das so aus:

Was passiert, wenn schwäbische Hausfrauen Sozialpolitik machen: Lebenswerwartung in Griechenland (Daten: CC-BY-SA Weltbank).

Da mag 2020 ein wenig Corona dabei sein, das Ende des Anstiegs der Lebenswerwartung war jedoch auch vorher schon sonnenklar. Wer will, kann aus dieser Kurve mit einigem Recht schätzen, dass Schäubles Politik den GriechInnen inzwischen zwei Lebensjahre geraubt hat. Und wer sich schon so weit in diese Sorte Metriken begeben hat, kann auch gleich weiterrechnen.

Griechenland hat um die 107 EinwohnerInnen. Mithin sterben dort jedes Jahr um die 105 Menschen (weil sie so in etwa 102 Jahre alt werden). Wenn die jetzt im Schnitt zwei Jahre kürzer leben, gehen aufgrund von Schäubles Politik Jahr für Jahr rund 200'000 Lebensjahre in Griechenland verloren. Das lässt sich noch etwas krasser ausdrücken: Wer ein mittelgroßes Stadion mit 104 Plätzen, also in etwas wie den…

… Audi-Sportpark (Foto: CC-BY-SA Chaddy)…

…mit 60-Jährigen (die noch eine Restlebenswerwartung von 20 Jahren haben) füllt, das dann mit einer hinreichend großen Bombe sprengt und innerhalb eines Jahres das Stadion wieder aufbaut, um das Ganze zu wiederholen: So jemand sorgt für ein vergleichbares Blutbad.

Das ist kein Unfall. Schäuble hat eine so konsequente Verarmungs- und Privatisierungspolitik gerade auch im Gesundheitswesen erzwungen, dass über deren Ergebnisse von vorneherein keine Zweifel bestehen konnten. Er kann schlicht nicht sagen, dass er das Gemetzel nicht gewollt habe.

(2) Als Innenminister (1989/1990 und wieder 2005-2009) hat Schäuble legendär im Bereich der Menschenrechte gewütet. Erwähnt seien hier etwa

- die Erfindung der „Antiterror“-Datei, mit der unter anderem das uns von den Alliierten geschenkte Trennungsgebot von Polizei und Geheimdienst ziemlich obsolet würde (wenn nicht das Misstrauen zwischen Polizei und Geheimdiensten noch einen gewissen Restschutz böte).

- in diesem Zusammenhang die Erfindung eines „Supergrundrechts auf Sicherheit“, das noch jede Aushebelung von Menschenrechten rechtfertigen würde und so quasi die Urmatrize autoritärer Politik darstellt.

- die wesentliche Beförderung (gut: im Einklang mit seinen Länderkollegen) des Staatstrojaners, auch wenn er, als sein Werk 2011 spektakulär explodierte, schon dem Finanzministerium vorsaß.

- die drastische Ausweitung von „Zuverlässigkeitsprüfungen” im Vorfeld der Fußball-WM der Männer 2006, seit der es ganz normal ist, dass über Menschen, die, sagen wir, Würstel in Fußballstadien verkaufen wollen, Auskunft bei den Polizeien eingeholt wird und so die üblichen und willkürlichen Datenspeicherungen der Exekutive existenzgefährdend werden können.

- die Aushandlung und Durchsetzung des Vertrags von Prüm, mit dem unter anderem diese willkürlichen Daten über politisch missliebige und andere Personen quer durch Europa verschoben werden dürfen.

- die Nutzung dieses Mechanismus beim NATO-Jubiläum 2009 in Baden-Baden, Kehl und Straßburg, um mutmaßliche GegendemonstrantInnen von den französischen Behörden abfangen zu lassen, nachdem Gerichte Schäuble untersagt hatten, das von deutschen Behörden erledigen zu lassen.

- vergleichbar das wüste Vorgehen gegen die Proteste gegen den G8-Gipfel in Heiligendamm im Jahr 2007 mit großflächigen Hausdurchsuchungen im Vorfeld, gewaltigen Sperrzonen, militärischen Polizeieinsätzen und Polizeieinsätzen des Militärs („russische Verhältnisse“ sagte damals sogar Attac; weniger gleichmütige Stimmen haben weit drastischere Bilder).

Undsoweiterundsofort. Ich könnte weiter machen mit den Fiesheiten, die er in den Einigungsvertrag mit der DDR hat reinschreiben lassen, seiner düsteren Rolle in der Kohl-Spendenaffäre, seiner Verwicklung in Cum-Ex oder vielem mehr. Keine Frage: Schäuble ist ein Schurke, der konsequent immer auf der falschen Seite jeder Geschichte stand.

Und was erzählt dieser Mensch nun im taz-Interview, warum er im Jahr 2000 in der Politik geblieben ist, warum er also letztlich die Mehrzahl der hier aufgezählten Schurkigkeiten begangen hat?

Als ich nach der Spendenaffäre als Fraktions- und Parteivorsitzender zurückgetreten war, war für mich eigentlich klar, dass ich nicht mehr für den Bundestag 2002 kandidieren werde. Aber für einen 60-Jährigen, der seit 10 Jahren im Rollstuhl sitzt und seit 30 Jahren in der Politik ist, waren die Möglichkeiten, etwas anderes zu machen, nicht so groß. Ich wollte keinen Lobbyposten. [...] Ich war vor 1972 in der Steuerverwaltung und bin Lebenszeitbeamter mit Rückkehranspruch. Aber mit 60 Jahren in die Steuerverwaltung zurückzukehren, war auch keine attraktive Idee.

Also im Groben: Er hat den sozialen Abstieg gefürchtet.

Ein schon damals alter, aber machtgewohnter Mann hat all den Schaden angerichtet, weil er sich um sein Ansehen sorgte. Und das in einer bemerkenswerten Verdrehtheit, denn auf die Frage, warum er wohl keinen Lobbyposten wollte, antwortet er: „Ich mache nicht alles.“ Was wohl zu lesen ist als: Die Leute, die sich kaufen ließen, um Einfluss auf die Politik zu nehmen (ein paar Beispiele: Kohl für Kirch, Fischer für BMW, Koch für Bilfinger Berger, Schröder für Gazprom oder gar Oettinger für Rosatom und mein Liebingsbeispiel Berninger für Mars) sind irgendwie noch schlechter als jemand, der hunderttausende Lebensjahre raubt und das Grundgesetz rupft.

Nun wäre es ja denkbar, dass Schäuble auch mit weniger fieser Politik den Sozialstatus erhalten hätte, den er haben wollte. Wie kam er also ausgerechnet auf die Schurkereien, die er wirklich verfolgt hat? Er erläutert das so:

Ich hatte immer meinen eigenen Kopf. Aber ich bin loyal. [...] Ich habe Kohl gesagt: Ich mache, was er machen würde, wenn er sich mit den Dingen beschäftigen würde. Ich mache, was in seinem Interesse ist. Das ist mein Verständnis von Loyalität.

Das war schon lange meine Vermutung: Wenn Leute Politik machen, die offensichtlich eklig oder falsch ist, liegt es fast immer daran, dass sie irgendwem und vor allem irgendwas (typisch: dem, was sie „Volk“ nennen; siehe) gegenüber loyal sein wollen und dieser Loyalität Einsicht und Empathie unterordnen.

Und ja, ich glaube tatsächlich, dass Leute wie Schäuble solche Bekundungen ernst meinen. Anders könnten sie, denke ich, mit all dem Mist, den sie mit ihrer „Verantwortungsethik“ angerichtet haben, gar nicht leben, jedenfalls, wenn ihre Boshaftigkeit tatsächlich banal ist. Das wiederum schien mir bei Schäuble bereits angesichts seines naiven Gequatsches von schwäbischen Hausfrauen schon immer nahezuliegen. Das Interview in der taz hat diesen Eindruck noch verstärkt.

![[RSS]](./theme/image/rss.png)