Von Produktion und Reproduktion

Dass KrankenpflegerInnen weit schlechter bezahlt werden als die Leute, die Autos zusammenschrauben, mag sehr nachvollziehbare Gründe haben[1]; es illustriert aber auch die generelle Tendenz entwickelter kapitalistischer Gesellschaften, Produktion weit höher zu gewichten als Reproduktion. Augenfällig ist das ganz sicher darin, dass familiäre oder ähnliche Reproduktionsarbeit nach wie vor im Wesentlichen unbezahlt stattfindet[2].

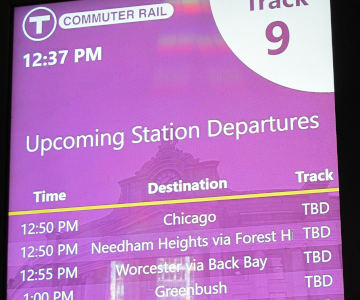

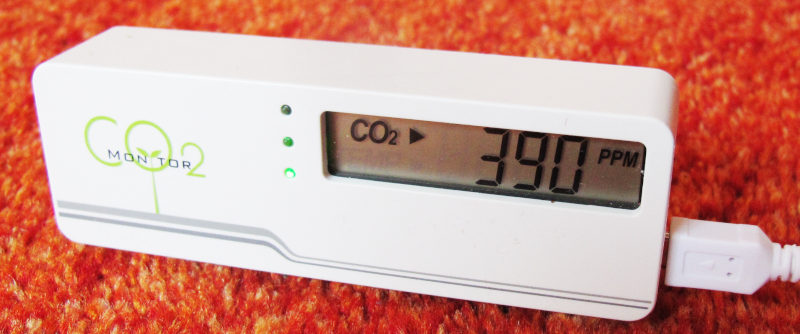

Eine besonders überraschende Variante des leicht apokalyptischen Mottos „Produktion schlägt Reproduktion“ habe ich jetzt gerade entdeckt. Dick Asche auf mein Haupt, aber meine Lohnarbeit verlangt es: Ich sitze in einem Flieger der Lufthansa. Und darin haben sie Kopfhörer ausgeteilt, die zusammen mit ihrer Verpackung so aussehen:

Was da auf die Verpackung gedruckt ist, würde ich übersetzen als:

Sie können diese Ohrhörer gerne nach dem Flug behalten. Wenn Sie das nicht wollen, geben Sie sie bitte am Ende des Fluges an die Crew zurück. Wir recyclen wiederverwendbare Teile der Ohrhörer in Deutschland.

Wow. Einweg-Kopfhörer. Dass es inzwischen billiger ist, die kleinen Lautsprecherchen, die lackierten Kupferlitzen, die Kunststoff-Ummantelung und den doch recht komplizierten Zweistandard-Stecker (für die alten Airline-Doppelklinken und die ganz normalen 3.5 mm-Klinken) neu zu fertigen als die schon produzierten Dinger einzusammeln und etwas zu reinigen: Das ist eine beeindruckende Optimierungsleistung.

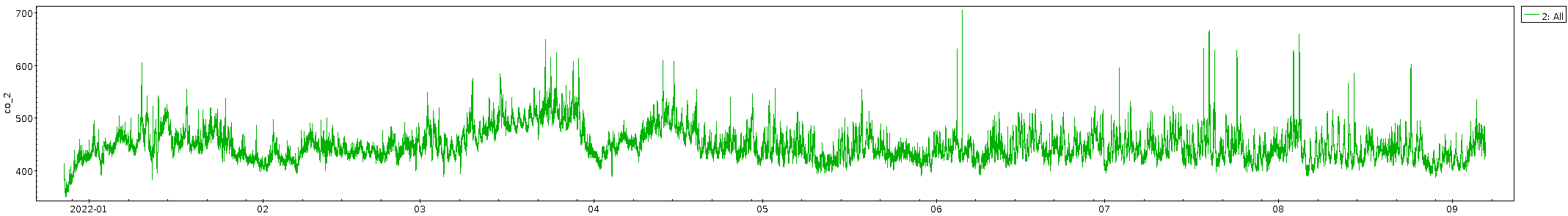

Gut: Es optimiert ganz sicher nicht auf verantwortungsvollen Umgang mit Rohstoffen. Einzuräumen ist jedoch, dass viel mehr als ein paar Kilo CO₂-Äquivalent schon aus Preisgründen nicht in den Dingern stecken kann[3], und das ist vernachlässigbar, da sie ja nun im Flieger anfallen und mithin in einer Situation, in der wir über Tonnen CO₂-Äquivalente sprechen, drei Größenordnungen mehr.

Doch ich wage nicht, den Fehler zu berichten.

Total verquer finde ich es trotzdem. Ich denke, die Tatsache, dass es im Rahmen eines Fluges schon auch egal ist, ob mensch noch ein Paar nagelneue Ohrhörer wegwirft oder nicht, ist eine ganz schöne Illustration dafür, dass die ganze Fliegerei etwas ist, das wir als Gesellschaft weitgehend überwinden sollten.

Wenn ihr euch fragt, warum ich überhaupt so eine Packung genommen habe, wo ich mit meinem guten alten N900 doch bestimmt Ohrhörer mit passendem Klinkenstecker dabei hatte: Nun, die Klinken-Buchse am Platz J56 in der Maschine hier ist offenbar ausgeleiert. Jedenfalls hatte ich mit meinem eigenen Ohrhörer meist null Audiokanäle, mit viel Geschiebe mal einen, fast nie beide. Ich dachte, das läge vielleicht an irgendeinem Luftfahrtpatent, das ein offizieller Ohrhörer wohl berücksichtigen würde.

Ist nicht so: Die Klinke im Flieger ist inzwischen genau die gleiche wie an euren Telefonen von vor zehn Jahren. Wenns nicht geht, ist die Buchse kaputt (oder euer Kopfhörer). Aber ich wage nicht, den Fehler auf J56 zu berichten, denn garantiert schmeißen sie dann gleich den ganzen Computer weg, an dem die Buchse hängt. Und das, das würde im CO₂-Budget selbst eines Transatlantikfluges auffallen.

Nachtrag (2025-06-06)

Also gut, ich gebe zu, dass ich nicht wirklich weiß, wovon ich bei „alte Airline-Klinke“ und „inzwischen genau die gleiche“ rede. In der B747-8, die mich gerade zurück in die BRD bringt, braucht es beispielsweise den Doppelstecker, den ich als „alte Airline-Klinke“ bezeichnet habe. Wie viel es davon in Wahrheit noch gibt: Keine Ahnung. Insofern: Wenn der Flieger nur eine Klinke hat, ist es der gleiche Stecker wie bei euren Telefonen vor zehn Jahren.

Nachtrag (2025-06-06)

Und wo ich schon schreibe, muss ich gleich nochmal beichten: Der Flug hier ist zwar ausgebucht, wird aber trotzdem eine besondere Ökosauerei. Er ist nämlich mit über einer Stunde Verspätung in Washington gestartet, und der Flugkapitän hat offen zugegeben, dass sie Extrasprit getankt haben, damit sie schneller fliegen können, um wenigstens etwas von der Verspätung reinzuholen. Asche rieselt in dicken Schwaden von meinem Kopf.

Seufz.

Kommentar 1 am 2025-07-21

Ich glaube nicht dass Engel Binnen-Is benutzen. Woker Anpasserismus.

Kommentar 2 am 2025-07-21

Oh… Neenee, nichts Anpasserismus. Ich bin eineR von denen, die das Hohe I seit irgendwann Anfang der 1990er – Jahrzehnte vor der Erfindung von „woke“ – durch eifriges Publizieren und Kommunizieren in allen möglichen Formen gesellschaftsfähig gemacht haben.

Und ich halte das für eine der verdienstvolleren Beschäftigungen, denen ich in all den Jahren nachgegangen bin. Mal ehrlich, „Dass Krankenpfleger weit schlechter bezahlt werden“ wäre angesichts der Geschlechterverhältnisse in dem Tätigkeitsfeld einfach extrem albern – jedenfalls, solange praktisch alle beim „Krankenpfleger“ ein klares Bild haben, wie es zwischen den Beinen der bezeichneten Person wohl aussehen wird. Und klar, natürlich haben sie das.

Dennoch danke fürs Feedback; ich hatte immer Sorge, dass die erste Kritik an der Genderschreibweise hier von Menschen kommen würde, die dringend inklusivere Formen (Unterstrich, Stern, Doppelpunkt) sehen wollen. Wenn diese jetzt kommen, kann ich belegen, dass auch das Hohe I (an dem ich aus Gründen der w/b-Tasten im vi, Doppelklicks in xterms und als Reverenz für Luise Pusch festhalte) noch prima wirkt.

| [1] | Übrigens gehört zu den möglicherweise nachvollziehbaren Gründen nicht der höhere Automatisierungsgrad in der Automobilindustrie, jedenfalls nicht, wenn mensch Marx sein Wertgesetz abkauft, nach dem sich der Wert einer Ware („oder Dienstleistung“ – warum klingt eigentlich jede Rede über „Wirtschaft“ so albern und abgedroschen?) nach der in ihr vergegenständlichten Arbeit bemisst. |

| [2] | Versteht mich nicht falsch: Dass Aufzucht und Pflege von Kindern und das wohnliche Zusammenleben von Erwachsenen sich immer noch zu guten Stücken der marktförmigen Organisation entzieht, ist wahrscheinlich im Hinblick auf <hust, wieder Marx> Entfremdung ganz gut so. Es ist jedoch dann doof, wenn sich Lebensrealitäten und -möglichkeiten (sagen wir mal: Leben ohne Lohnarbeit im Alter) nach Marktverwertbarkeit der Tätigkeiten der Individuen bestimmen; Altersarmut ist in der Folge nicht nur dem grammatischen Geschlecht nach weiblich. Mein Vorschlag zur Besserung der Situation wäre aber, lieber mehr Leben aus dem Markt herauszunehmen als ihm noch mehr Leben auszuliefern. |

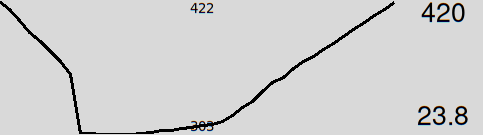

| [3] | Das ist eine Abschätzung auf der Basis der immer nützlichen Faustformel: „Wenn du einen Euro ausgibst, emittierst du ungefähr ein Pfund CO₂“ (vgl. die Fußnote 1 hier drüben); innerhalb eines Faktors zehn gilt das für fast alles, was mensch so kaufen kann, selbst für diesen Flug hier, der mit vermutlich etwa 2 Kilo pro Euro eher am oberen Ende der Kohlendioxydsünden liegt. Nachdem die Sorte Ohrhörer wohl nicht viel mehr als 10 Euro kosten wird, dürften auf dem Foto oben irgendwas zwischen 2 und 50 Kilo CO₂ vergegenständlicht sein. Und das Kupfer, das da drin ist? Nun: vielleicht recyclen die das ja tatsächlich. |

![[RSS]](../theme/image/rss.png)