Schwanengesänge auf den Wissenschaftsbetrieb

In diesem Raum werden sich gleich Menschen treffen, um zu besprechen, wie sie weiter Forschungsgeld beziehen können. „Sieht teuer aus?“ Nun, verglichen mit der Arbeitszeit, die da drin mit Nichtwissenschaft verbracht wird, fällt das kaum ins Gewicht. Und so kommt ein Schwanengesang dieser Sorte Wissenschaftsbetrieb nicht gerade zur Unzeit.

Seit fast 20 Jahren lebe ich als prototypischer Wissenschaftler: Alle drei Jahre schreibe ich einen Forschungsantrag (plus zwischendrin auch immer mal wieder einen für gelegentliche Zuckerl) und dann jedes Jahr pro Projekt einen Bericht (bei ungünstigen Mondphasen auch zwei), was von dem, was ich beantragt habe, auch wirklich passiert ist.

Das ist, was sich über die letzten gut 50 Jahre als das Modell herausgebildet hat, in dem etwas wie 80% der Wissenschaft stattfinden. Es gibt natürlich noch Leute im Betrieb, die mit festem Geld arbeiten, in der BRD in der Regel auf einer Professur. Aber die sind normalerweise fast nur noch damit beschäftigt, Anträge für andere zu schreiben oder zu begutachten oder im politischen Raum die Ausschreibungen zu beeinflussen, für die mensch die Anträge schreibt.

Ich will vor dem Weiteren sagen: Ich hatte es dabei vergleichsweise gut. Ich konnte nämlich dem BMBF[1] ehrlich sagen, was ich machen will (in den Anträgen) und was ich gemacht habe (in den Berichten) und habe trotzdem immer Geld bekommen. Das ist alles andere als selbstverständlich in einer Welt, in der das allgemeine Gefühl ist, mensch müsse mindestens Wunderdinge und Wirtschaftswachstum versprechen, um gefördert zu werden. Jedenfalls möchte ich bei dieser Gelegenheit einen herzlichen Dank loswerden an die Personen, die das beim BMBF und/oder beim Projektträger möglich gemacht haben.

Schädliche Metrik Ablehnungsquote

Trotz dieser versöhnlichen Worte war (nicht nur) mein Urteil schon immer, dass das ein bemerkenswert verrücktes System ist, denn unfassbar viel Mühe geht und ging in all die fast komplett unnütze Arbeit rund ums Antragswesen. Zudem haben die Verrenkungen, die WissenschaftlerInnen unternehmen, um das, was sie eigentlich tun wollen, irgendwie in das zu zwingen, was die Ausschreibungen zu fördern versuchen, viel tragikomisches Potenzial und setzen jede Menge Reibungswärme frei.

Über all dem steht und stand ein Publikationswesen, in dem immer mehr geschrieben werden muss und immer weniger gelesen werden kann, weil längst Metriken jeden Zweck überwuchert haben – und das en passant die wissenschaftlichen Bibliotheken ruiniert hat.

Ein gutes Beispiel für die drastische Ineffizienz dieses Systems ist das Gliese Fellowship[2] an der Uni Heidelberg. Es handelt sich dabei im Wesentlichen um ein gut ausgestattetes Stipendium für eine Person für drei Jahre. Dessen (natürlich globale) Bedeutung nun versuchen die lokalen ProfessorInnen regelmäßig zu belegen mit Aussagen des Typs: „Wir hatten über 250 Bewerbungen“.

Eine schnelle Überschlagsrechnung: Wenn mensch veranschlagt, dass jede Bewerbung zwei Arbeitstage gekostet hat – das mag etwas pessimistisch sein, denn Menschen in dieser Mühle haben in der Regel ihre Lebensläufe auf Stand, aber die Größenordnung wird als Mittelwert nicht ganz falsch sein –, dann sind allein für die AntragstellerInnen 500 Arbeitstage draufgegangen. Wie viel Aufwand die Begutachtung ist, kann ich glücklicherweise nicht sagen, aber wenn ich zwecks passender Zahlen drei Stunden pro Bewerbung veranschlage, anderthalb Stunden pro GutachterIn – wenn das weniger ist, dann taugt die Begutachtung nichts –, wären das nochmal knapp 100 Arbeitstage für die 250 Bewerbungen.

Nun hat ein Jahr etwa 200 Arbeitstage. Das Verfahren, das plausiblerweise 600 Arbeitstage frisst, verschlingt also genauso viel Arbeitszeit wie es finanziert. Diese Rechnung sieht noch finsterer aus, wenn (und das ist schon passiert) die StipendiatInnen mitten in ihrer Zeit einen attraktiven Ruf bekommen und schon vor dem Ablauf der drei Jahre weiterziehen.

Härtere Zahlen

In Forschung aktuell vom 8.1.2026 hat nun Gerhard Schweiger eine genauere Untersuchung dazu vorgestellt. Schweiger arbeitet an der TU Wien und hat ganz austriakisch die beeindruckenden Titel „Univ.Prof. Mag. Dr.techn. PhD“ für „Integrale Gebäudetechnik“. Ich gestehe, dass ich aus dieser Ecke keine scharfsinnige Analyse der Forschungsförderung erwartet hätte.

Aber siehstemal, er hat am 18. Dezember eine Diatribe in Nature platziert [ich linke ja normal nicht auf Paywalls, aber hier heiligt der Zweck die Mittel; für die libgen: doi:10.1038/d41586-025-04060-x] zu den „points of no return“. Ein schönes Wortspiel übrigens, denn nach Lektüre des Artikels wird klar, dass das „return“ in der titelgebenden Kollokation in der Lesart aus „return on investment“ verwendet ist und damit die Kollokation eigentlich bricht.

Sein Beispiel ist ein EU-Programm namens „GenAI for Africa“; ich weiß, „wenn schon AI drinsteht…“, und „for Africa“ ist bei der EU ein echtes Alarmzeichen (Beispiel EUTMs; Beispiel GASP). Auch wenn im konkreten Fall also ganz besonders wenig Gutes zu erwarten steht, decken sich seine Ergebnisse so schön mit meinem Bauchgefühl, dass ich sie sofort für generalisierbar halte.

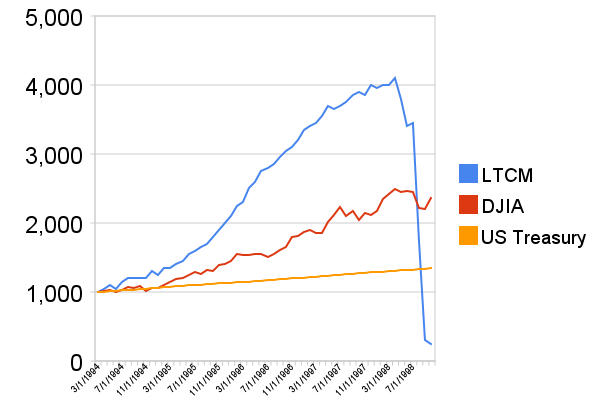

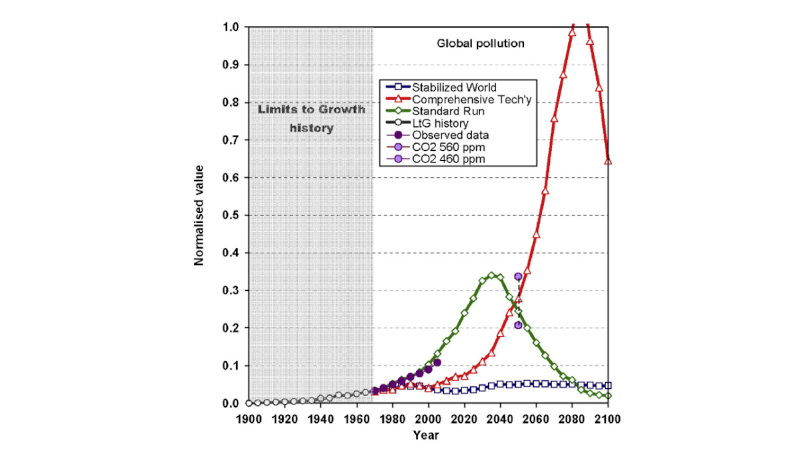

Das zentrale Ergebnis ähnelt meiner Abschätzung oben: Der Auswahlprozess kostet mindestens ebensoviel wie das, was vergeben wird. Schweiger hat dazu vier Szenarien berechnet und ist auf folgende Verfahrenskosten gekommen:

| Scenario | Proposals | Decision-making | Administration | Total |

| A1 | — | — | — | 7,575,300 |

| A2 | — | — | — | 43,473,000 |

| B1 | 4,515,000 | 532,000 | 266,000 | 5,313,000 |

| B2 | 6,880,000 | 809,000 | 405,000 | 8,094,000 |

Szenario A geht davon aus, dass pro Projektpartner 16 bis 25 Personentage anfallen bei so einem Antrag. Für die üblichen „wie kriege ich das, was ich eigentlich tun möchte, mit dem Ausschreibungstext zusammen“-Anträge ist das deutlich mehr als nach meiner Erfahrung tatsächlich anfällt. Aber selbst wenn das nur vier Personentage sein sollten (viel weniger werdens nicht, allein schon, weil es so ein Aufwand ist, sich KPIs[3] aus den Finger zu saugen): wir wären immer noch bei minimal zwei Millionen Euro Kosten für die völlig unproduktive wettbewerbliche Mittelvergabe, in diesem Fall für eine Ausschreibung mit einem Etat von rund 5 Millionen Euro.

Leo Szilárds Vorschlag von 1948

Im Deutschlandfunk hat Schweiger das so erklärt:

Und das Ergebnis war: Selbst bei den niedrigsten Annahmen waren die Kosten des Bewerbungsprozesses, also bevor überhaupt was ausgeschüttet wurde, mehr als fünf Millionen Euro, also mehr als am Ende überhaupt in die Forschung floss. […] Ich glaube, das ist definitiv ein extremerer Fall, aber es gibt auch andere Fälle auf allen Kontinenten, wo dieser Szilárd-Punkt überschritten wurde, und es ist auch wichtig zu sagen: Das Ziel kann nicht sein, dass wir den Szilárd-Punkt nur minimal unterschreiten

Szilárd-Punkt? Nun, das ist, wenn die Verwaltung kein Geld mehr übrig lässt, um etwas zu verwalten. Der Begriff kommt aus der sehr lesenswerten Kurzgeschichte The Mark Gable Foundation des Kernphysikers, Bombenbauers und Molekularbiologen Leó Szilárd[4] – die ich auch erst durch Schweigers Arbeit kennengelernt habe.

Balsam auf meine Seele ist, dass Schweigers Schluss ein ähnlicher ist wie der, mit dem ich Ende der Nullerjahre von früher Antragsübersättigung gepeinigt meine KollegInnen entsetzt habe: „Besser auswürfeln“ war mein rollenspielgeprägtes Rezept. Bei Schweiger liest sich das etwas weniger provokativ:

Genau, also das Thema, das Sie angesprochen haben, Lotterie… ist gerade jetzt eine sehr breit diskutierte Studie wieder von den Kollegen in Lübeck publiziert worden, wo man einfach Lotterie einsetzt, um Forschungsgelder zu verteilen. Jetzt mag das für die Zuhörerinnen und Zuhörer komisch klingen in einem ersten Fall, aber dann ist wichtig zu wissen, dass der Auswahlprozess im Wettbewerb auch mehr oder weniger Zufall ist.

Nun, nach meinem Loblied auf das alte BMBF am Anfang dieses Posts würde ich das mit dem „Zufall“ vielleicht gerne zurückhaltend relativieren wollen. Aber ich bin zum Glück nicht eingebildet genug, um es wirklich zu tun.

Das Ende des AJ

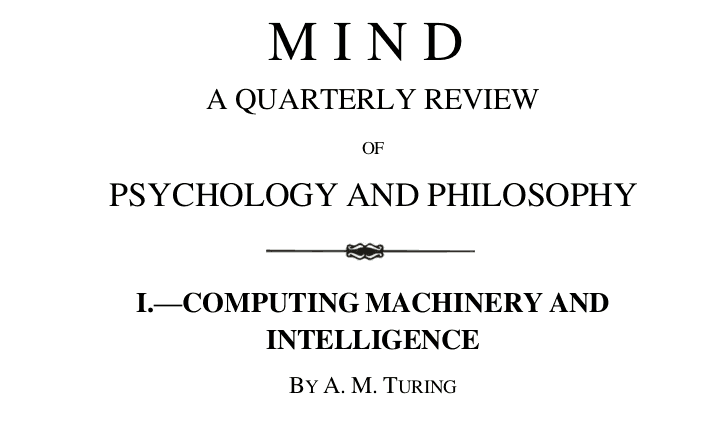

Neben der gigantischen Geldverschwendung durch wettbewerbliche Mittelvergabe ist das zweite große Problem unseres Wissenschaftsbetriebs die Fehlsteuerung des Erkenntnisprozesses durch das Publikationswesen: Das Zählen von veröffentlichen Artikeln und Zitationen macht es im Wesentlichen unmöglich, erst dann zu publizieren, wenn mensch wirklich was zu sagen hat.

Die publikationsbasierte Metrisierung bringt weiter rational abwägende Menschen dazu, nur an Dingen zu arbeiten, bei denen innerhalb weniger Monate absehbar etwas rauskommt, das in einer Zeitschrift unterzubringen und dann auch möglichst breit zitierbar ist. Riskante oder exotische Themen können sich erst Menschen leisten, die mit ihrer „Karriere“ abgeschlossen haben, und das ist bei Befristungsquoten von 80% ein Luxus, den sich nur wenige leisten können.

Wie wir in diesen spezifischen Schlamassel reingekommen sind, erzählt recht schön (wenn auch mit in KI-Zeiten schockierend vielen Tippfehlern) Russell Beale in seinem Paper In Memoriam: The Academic Journal.

Wer die Geschichte des akademischen Publizierens nicht gut kennt, findet hier eine knappe und erhellende Übersicht mit einer Prise Augenzwinkern, inklusive der Erklärung, dass es letztlich das Ende der großzügigen Ausweitung der Forschungsetats in den frühen 1970er Jahren war, das den Wettbewerb so richtig lostrat und dafür gesorgt hat, dass Journals von Instrumenten des Austauschs von Erkenntnissen zu Waffen und Hindernissen im Überlebenskampf wurden und dadurch ihrer eigentlichen Funktion immer schlechter nachkommen konnten – selbst wo sie das ehrlich wollten.

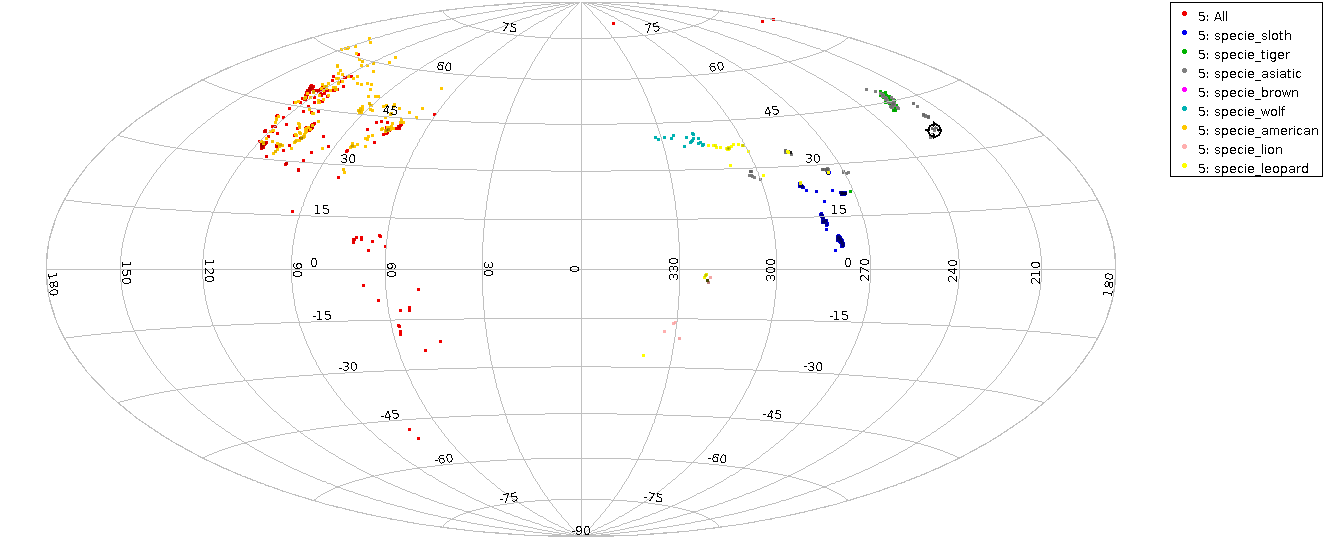

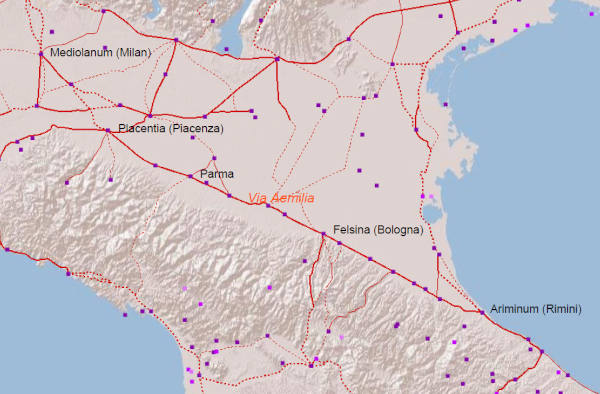

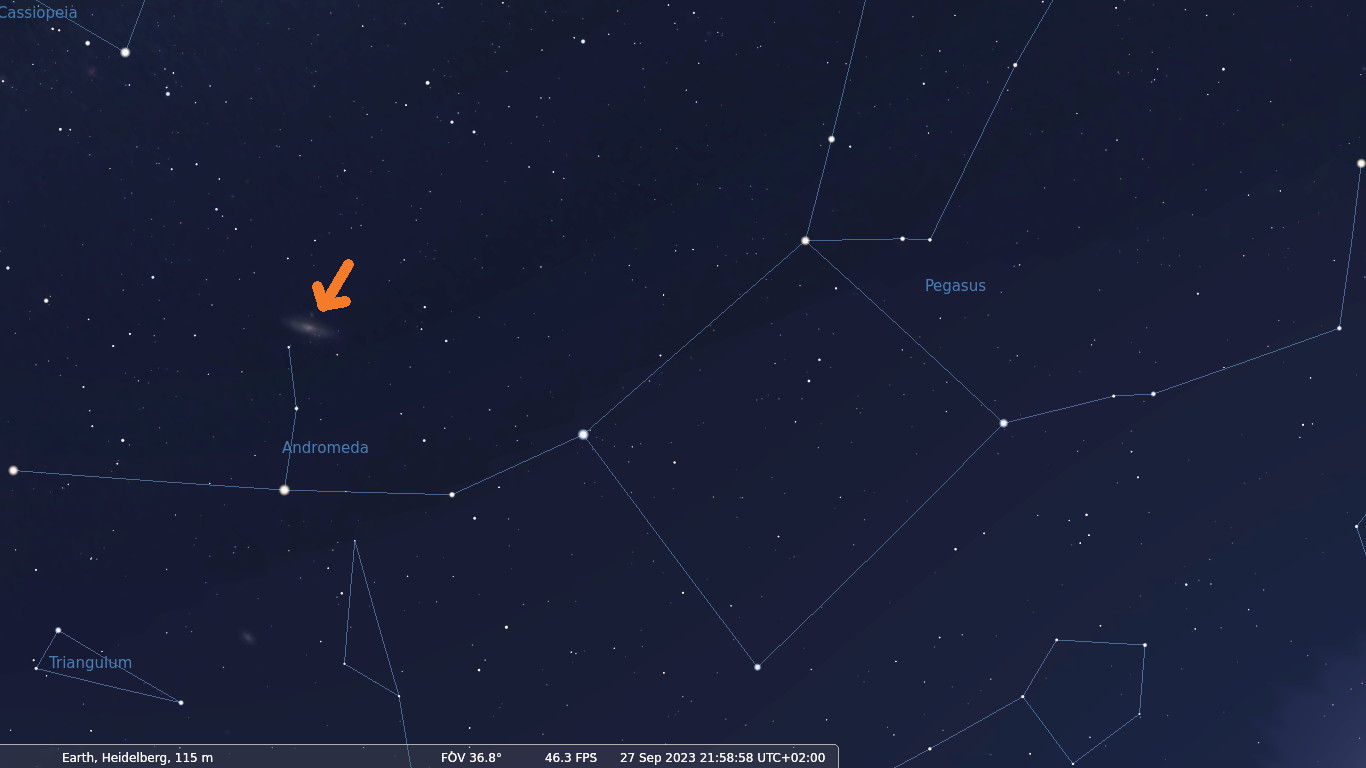

Letztere, Journals, die nicht wesentlich Geld verdienen, sondern Wissen verbreiten wollen, gibt es übrigens tatsächlich, auch wenn Beale das als Computermensch nicht auf dem Schirm haben wird. In der Astronomie sind wir gesegnet dadurch, dass die wichtigsten Publikationen (AJ – hier nicht Academic, sondern Astronomical Journal –, ApJ, MNRAS [sorry: Cloudflare], A&A) alle von „Learned Societies“, nämlich der AAS, der RAS und der …

![[RSS]](../theme/image/rss.png)

![Ein fotografierter Text, in dem u.a. steht „die sogenannte Große Magellan'sche Wolke [...] und den Andromedanebel auf, zwei Galaxien des südlichen Sternenhimmels“](/media/2023/liebieghaus-andromedanebel.png)