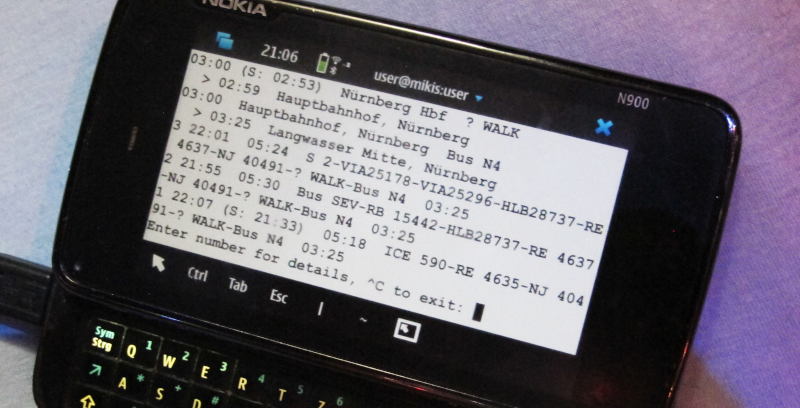

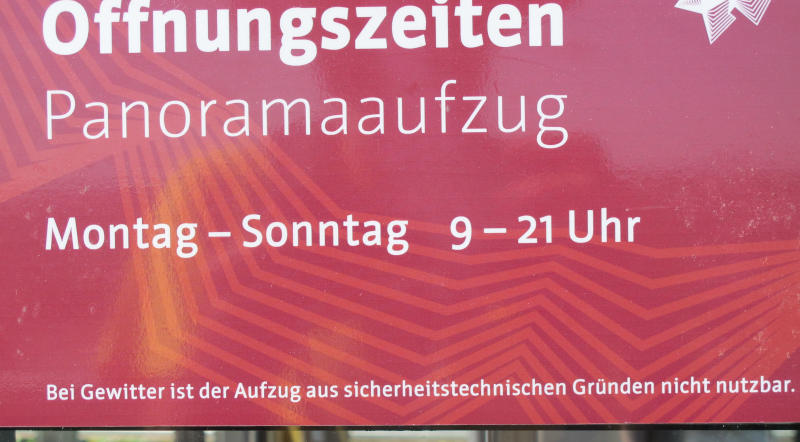

Sicherheitstechnische Gründe?

Als ich dieses Schild an einem Aufzug in Erfurt gesehen habe, fand ich, mensch könne viel daraus lernen. Ungefähr davon handelt dieser Post.

In Erfurt kann mensch bequem im Aufzug auf die Bastion am Petersberg hochfahren[1], was zu einem hübschen Aussichtspunkt führt; die gut zehn Meter, die der Aufzug überwindet, machen einen erheblichen Unterschied im Überblick aus. Ohne Probleme ist von dort oben zum Beispiel bei passendem Wetter der Glockenturm des Buchenwald-Denkmals am Weimarer Ettersberg auszumachen.

Ihr dürft die Fahrt aber offenbar nicht während eines Gewitters versuchen; jedenfalls warnt davor (realistisch: verbietet das) das oben abgebildete Schild in der Maschine: „Bei Gewitter ist der Aufzug aus sicherheitstechnischen Gründen nicht nutzbar.“ Nennt mich empfindlich, aber das Schild hat mich ein wenig provoziert. Zugestanden: An sich ist es ja gut, wenn Verbote gleich vor Ort begründet werden.

Aber es ist erstens bereits etwas wieselig, wenn sich, wer immer das Schild montieren hat lassen, um die Tatsache des Verbots mit einem apodiktischen „nicht nutzbar“ herummogelt. Nutzbar käme in Frage, wenn etwa die starken elektrischen Felder des Gewitters den Motor störten. Aber das ist gewiss nicht der Fall. In Wirklichkeit sollte dort der Ehrlichkeit halber stehen: „Bei Gewitter ist die Nutzung des Aufzugs verboten“.

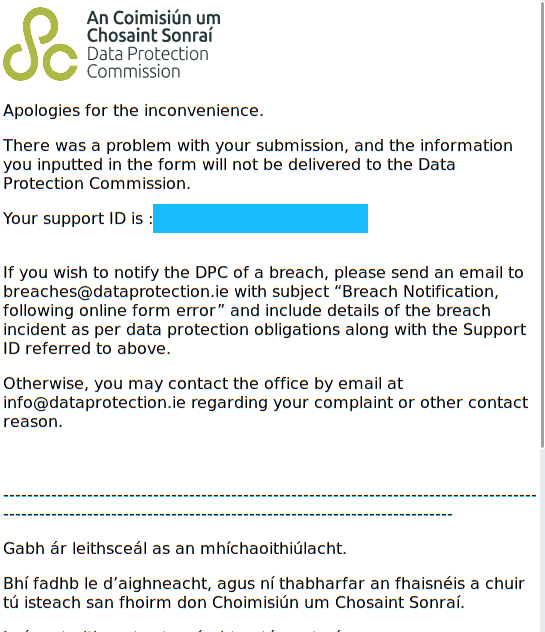

Vom oberen Ende des Aufzugs aus sind der Ettersberg und der Buchenwald-Glockenturm zu sehen[2].

Doch hätte mich diese kleine Wieselei allein nicht an die Tastatur getrieben. Nein, Schuld an diesem Post hat der Inhalt der Begründung, so erfreulich ihr Vorhandensein zunächst auch sein mag. Wieder könnt ihr mich pingelig nennen, weil mich so kleine Details stören. Aber ich behaupte, starke Gründe zu haben. Die verrate ich allerdings erst am Schluss.

Denn zweitens wäre das „sicherheitstechnisch“ der Gründe richtig, wenn bei Gewitter die Sicherheitstechnik (also, sagen wir, die Notbremse) nicht funktionieren würde. Dafür kann ich keinen plausiblen Mechanismus erkennen. Klar: Die Bremse könnte nicht funktionieren, wenn es draußen nass ist, aber dann wäre das Kriterium Regen und nicht Gewitter, und ich kann mir auch nicht vorstellen, dass der TÜV sowas abnehmen würde (obwohl).

Lasst mich stattdessen experimentell kurz die „Sicherheit“ streichen: „Technische Gründe“ würden ähnlich wie „nicht nutzbar“ letztlich behaupten, dass die ganze Maschinerie (und nicht nur die Sicherungsmaßnahmen) bei Gewitter einfach nicht funktioniert. Ich wette hohe Quoten, dass dem nicht so ist.

Es bleibt: „Aus Sicherheitsgründen“. Das ist glaubhaft, angefangen davon, dass Gewitter immer noch ein erhebliches Risiko für Stromausfälle mit sich bringen und mensch nicht mitten während der Fahrt steckenbleiben will (auch wenn das in der Glaskonstruktion gerade bei Gewitter bestimmt ein Erlebnis wäre). Wahrscheinlich wäre es weiter sehr ungesund, wenn ein Blitz gerade dann in die Konstruktion einschlägt, während mensch ein- oder aussteigt, und sicher treffen das aufragende Stahlgebilde deutlich mehr Blitze als irgendeine Stelle am, sagen wir, benachbarten Domplatz.

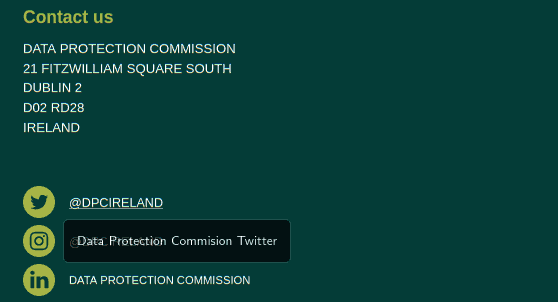

Warum aber hat da nun irgendwer das „technisch“ reingeschrieben? Ich weiß es natürlich nicht, aber ich vermute eine Parallele zu, und hier kommen wir zum eigentlichen Grund für diesen Post, „datenschutzrechtlichen Gründen“: Da will sich wer durch Extrawörter distanzieren. Das ist bei „sicherheitstechnisch“ genau betrachtet vielleicht kein schlechtes Zeichen für den Zustand der Gesellschaft.

Bei „datenschutzrechtlich“ wird es ziemlich furchtbar. Wer sowas sagt, hat sich entweder etwas gedankenlos anstecken lassen – oder distanziert sich recht explizit vom Datenschutz. Denn eigentlich geht es ja, wenn du irgendwelche Daten verarbeitest oder besser es nicht tust, nicht in erster Linie ums einfache Recht, sondern mindestens um Grundrechte, konkret etwa um die Selbstbestimmung (<hust> „Würde“) etwaiger Speicheropfer. Du sollst, so spricht I/O, die Göttin der Informatik, unethische DV nicht lassen, weil sie verboten ist, sondern weil sie unethisch ist.

„Datenschutzrechtliche Gründe“ klingt nach „Ich würds ja machen, aber die fiesen Gesetze lassen mich nicht“. „Datenschutzgründe“ hingegen heißt: „Menschen, die ihre Mitmenschen gut leiden können, tun sowas nicht“.

Zumindest ich weiß, welche der beiden Nachrichten ich senden will.

| [1] | Wenn ihr dort seid, besucht doch auch das Denkmal für den unbekannten Wehrmachtsdeserteur. Es ist zwar etwas schade, dass das Gedenken dort auf Menschen eingeschränkt ist, die genau nur den NS-Streitkräften den Rücken gekehrt haben, fast als sei Morden für Macht anderweitig möglicherweise eine gute Idee. Aber es ist schon mal großartig, überhaupt Menschen daran zu erinnern, dass Desertion nicht nur möglich, sondern auch lobenswert ist. |

| [2] | Dieser Blick eröffnete sich übrigens auch Kurt Prüfer an seinem Zeichenbrett im dritten Stock des (noch stehenden) Verwaltungsgebäudes der Maschinenbaufirma Topf und Söhne. Prüfer war der Ingenieur, der die Hochleistungskrematorien in Buchenwald und Auschwitz entwickelt hat. Das ist nachzuvollziehen im sehr empfehlenswerten Erinnerungsort Topf und Söhne, ein paar Schritte vom Erfurter Bahnhof entfernt. |

![[RSS]](../theme/image/rss.png)