Horröses Heidelberg 2: Die Lenard-Säule

Heidelberg war selten eine sonderlich progressive Stadt. Gerade die zahlreichen Studentenverbindungen – Buschenschaften, Corps, Turnerschaften und was sich da sonst noch so im patriotischen Sumpf suhlt(e) – sorg(t)en für einen reichen Nährboden für jede Sorte rechten Wahnsinns. Von militaristischen Aspekten davon war im ersten Teil von Horröses Heidelberg schon die Rede. Dieses Mal habe ich rabiaten Antisemitismus im Angebot:

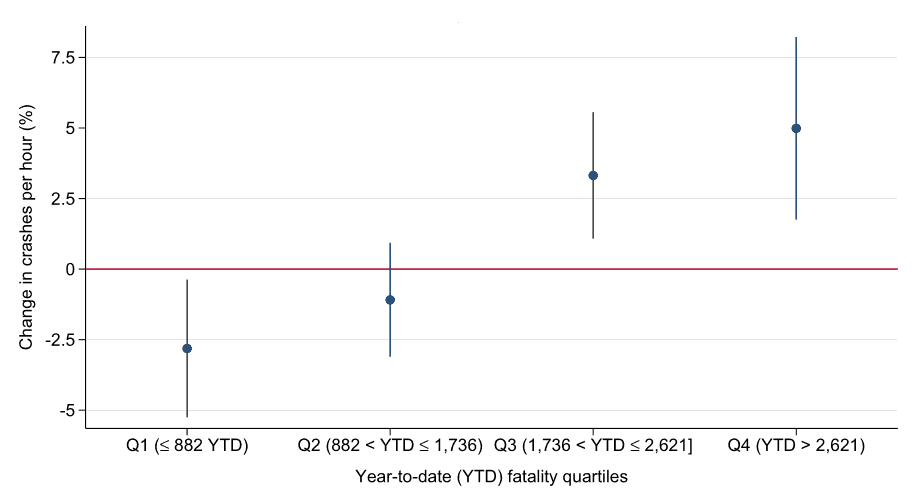

Die mutmaßliche Lenard-Säule.

Diese eher langweilig aussehende Installation findet sich im alten Physikgebäude im Philosophenweg 12, hinter einer Tür gegenüber dem unteren Ausgang des großen Hörsaals. Wenn die Geschichte, die ich jetzt gleich erzählen werde, ungefähr wahr ist, dann ist sie ein bizarres Denkmal antisemitischer Verblendung.

Vorneweg: Ich weiß offen gestanden nicht, wie wahr die Geschichte des Klotzes ist. Sie ist etwas, das sich Physikstudis von Generation zu Generation erzählt haben und das sehr plausibel klingt. Bevor ich sie in einer seriösen Publikation erzählen würde, würde ich vermutlich lieber erstmal die Bau-Unterlagen im Uni-Archiv einsehen wollen.

Philipp Lenard sucht den Äther...

Aber jetzt die Geschichte: Anfang des 20. Jahrhunderts ärgerte sich ein gewisser Philipp Lenard – bereits im Besitz eines Physik-Nobelpreises – über die damals aufkommende „neue“ Physik zwischen Quantenmechanik und Relativitätstheorie. Seit 1907 leitete er das Institut für Physik und Radiologie der Uni Heidelberg, und je länger er dort Geistesgenossen um sich sammelte, desto durchgeknallter wurde der ganze Laden. Schließlich publizierte er ein Machwerk unter dem Titel „Deutsche Physik“, das noch in den 1930er Jahren versuchte, die Welt ohne die Physik des 20. Jahrhunderts – aus Sicht der Deutschen Physiker: die „jüdischen Beiträge“ – zu erklären.

Das scheiterte natürlich, und noch nicht mal besonders grandios. In meiner Studienzeit gab es aber in der Bibliothek der angewandten Mathematik noch abgegriffene Exemplare der Deutschen Physik, deren Mischung aus normaler Standard-Physik und patriotischer Verwirrung wirkt, als habe sich ein normaler Studienrat eine Anfallskrankheit eingefangen, die ihn dann und wann in Erich von Däniken verwandelt (Literarische Referenz).

Lenard arbeitete sich vor allem an der speziellen Relativitätstheorie ab. Diese entstand ja in Teilen, weil das Michelson-Morley-Experiment mit der voreinsteinschen Licht-Theorie (Licht war danach wie Schall in der Luft, nur wäre die Luft fürs Licht ein Zeug namens Äther gewesen) echte Schwierigkeiten hatte: Mit jeder nicht ganz abseitigen Äthertheorie hatte mensch in diesem Experiment zumindest den „Fahrtwind“ der Bewegung der Erde um die Sonne sehen müssen[1].

Und hier kommt der Klotz auf dem Bild oben ins Spiel: In der Studi-Überlieferung nämlich hat ihn Lenard, für den das hässliche Physik-Gebäude am Philosophenweg gebaut wurde, einbauen lassen, um auf ihm Michelson-Morley-Versuche zu machen. Eine wesentliche Schwierigkeit bei diesen war nämlich das Wackeln des Untergrunds und das davon ausgelöste Rumzittern der Interferenzstreifen. Die Wikipedia schreibt zum Originalexperiment von 1881 derzeit, um „die Erschütterungen zu minimieren, wurde der Verkehr [beim Originalexperiment] weiträumig abgesperrt“. Diese Möglichkeit bestand am Rande des dicht besiedelten Neuenheim natürlich nicht.

Hier spielt diese Folge des horrösen Heidelbergs: Der Lenardbunker im Philweg 12.

...und kommt zu nichts

Der Lenard'sche Klotz nun soll fest mit dem Grundgebirge verbunden sein und auf dieses Weise eine erschütterungsarme Umgebung bieten. Ich persönlich glaube nicht, dass das funktioniert hätte, denn vermutlich schwingt das Grundgebirge nicht viel weniger als alles andere, und ohne Entkopplung vom Rest des Gebäudes – von der nichts zu erkennen ist – wäre auch eine größere Ruhe des Grundgebirges nicht sehr hilfreich. Ich weiß darüber hinaus nicht, ob Lenard wirklich jemals Zeit fand, nach seinem arischen Äther zu suchen.

Vermutlich nicht, denn er kämpfte an vielen Fronten. Ein Beispiel: Nachdem Freikorpsleute am 28. Juni 1922 den selbst eher konservativen Außenminister Walther Rathenau erschossen hatten, hatte die Reichsregierung eine allgemeine Arbeitsruhe angeordnet. Lenard und seine protofaschistischen Mitarbeiter konnten sich das schon wegen Rathenaus jüdischer Herkunft nicht vorstellen und werkten weiter. Das blieb auch wegen keineswegs auf Halbmast gezogener Fahnen nicht unbemerkt, und fortschrittliche AktivistInnen versammelten sich vor dem Institut. Dieses befand sich bereits seit 1913 am Philosophenweg; wer heute dort steht, steht also auf dem historischen Grund der Kundgebung.

Zunächst hinderte Polizei die DemonstrantInnen an einer Institutsbesetzung, aber die Situation eskalierte, als die Männer im Institut die Kundgebung mit Wasser aus Feuerwehrschläuchen unter Beschuss nahmen. Schließlich stürmten die DemonstrantInnen doch das Physikgebäude, und die Polizei musste Lenard in „Schutzhaft“ nehmen. Für Leute seines Schlages bedeutete das allerdings nicht, wie wenig später für allerlei den NS-Behörden verhasste Menschen, Darben im KZ, sondern eine komfortable Hotelübernachtung.

Vom Weitermachen und Einfahren

Immerhin sah sich der damalige badische Unterrichtsminister – wie Rathenau ein DDP-Mann und darüber hinaus selbst ehemals an der Heidelberger Uniklinik beschäftigt – nach Lenards Provokation bemüßigt, ihn zu suspendieren. Lenard antwortete nach außen mit einem Entlassungsgesuch, zu seinen reaktionären Freunden hin aber offenbar mit Unterstützungsappellen. Jedenfalls liefen nicht ganz ein Jahr später, am 1. Juni 1923, etliche konservative Studis beim engeren Senat der Uni auf und überreichten über 1000 Unterschriften, die Lenards bedingungslose Weiterbeschäftigung forderten. Tatsächlich blieb Lenard unangefochten bis zu seiner Emiritierung 1932 Leiter des Instituts für Physik und Radiologie.

Das ging Carlo Mierendorff anders; er war 1922 schon ein stadtbekannter Linker, und so stürzte sich der Staatsschutz begeistert auf ihn, als er in der Menge vor der Lenard'schen Festung auffiel. Am 10. April 1923 eröffnete ein längst vergessener Richter ein Gerichtsverfahren gegen ihn wegen eines in den heutigen Analoga immer noch nur zu vertrauten Delikts: Landfriedensbruch. Das ist auch aktuell der gefühlt drittpopulärste Vorwurf, wenn die Polizei eher willkürlich DemonstrantInnen bestrafen will (nach Vermummung und dem entsetzlichen tätlichen Angriff nach dem 2017 neu erfundenen §114 StGB).

Der Staatsschutz hatte Mierendorff eine Handvoll Mitangeklagte an die Seite gestellt, deren Demographie ich mit meinen heutigen Augen faszinierend finde. Abgesehen von ihm (zu dem Zeitpunkt wohl promovierender Studi) waren das nämlich durchweg Nichtstudis: der Tagelöhner Jakob Black, der Bauarbeiter Martin Kratzert, der Metzger Martin Erle, die Schlosser Franz Josef Mohr, Wilhelm Heilmann und Friedrich Zobeley, der Kaufmann Karl Hopp und der Kanzleiassistent Franz Joseph Bolz. Ob das wohl charakteristisch war für die TeilnehmerInnen der Anti-Lenard-Demo im Juni 1922? Das ist schwer zu sagen, aber fraglos waren die Studis damals weit überwiegend reaktionär und damit gewiss kaum an Kritik an Lenard interessiert.

Mierendorff übrigens fuhr am Schluss als „Rädelsführer“ für vier Monate ein.

Vergiftete Atmosphäre

Die Atmosphäre in Lenards Institut blieb auch nach dessen Emeritierung kurz vor der Machtübergabe an die NSDAP vergiftet. Sein Nachfolger, der deutlich liberalere Walter Bothe, schmiss nach zwei Jahren entnervt hin und wechselte an das ebenfalls in Heidelberg befindliche Institut, das heute das MPI für medizinische Forschung ist. Dass der Lenard-Schuler Ludwig Wesch mit seinen SS-Kadern stundenlang über Bothes Büro exerziert hat, war vermutlich nur der handfesteste Teil des Terrors, der noch am 23. Dezember 1933 sogar den Fakultätsrat der naturwissenschaftlichen Fakultät beschäftigt hat, wie es aussieht, wiederum auf externen Druck hin, denn Vorsprache hielt damals Uni-Kanzler Stein persönlich.

Nur, um nicht falsch verstanden zu werden: Bothe war selbst auch überhaupt kein netter Mensch. Als die Wehrmacht im Sommer 1940 Paris überrannt hatte, lief Bothe zum Beispiel im Windschatten der Soldaten im Pariser Labor von Frédéric Joliot-Curie auf und untersuchte den Stand von dessen Arbeiten an einem Teilchenbeschleuniger (drei Jahre später gab es dann auch in Heidelberg ein Zyklotron). Und das ist noch so etwa das Netteste, was in seinem Institut passierte; die MPG gesteht selbst, an Bohes Institut sei „noch 1944 die Synthetisierung des hochtoxischen Nervengases Soman“, na ja, „gelungen“.

Ob es wirklich der Betonblock im alten physikalischen Institut ist, der all diese Geschichten erzählt, will ich wie gesagt nicht versprechen. Die Geschichten selbst allerdings haben sich so zugetragen und sind Teil des horrösen Erbes von Heidelberg.

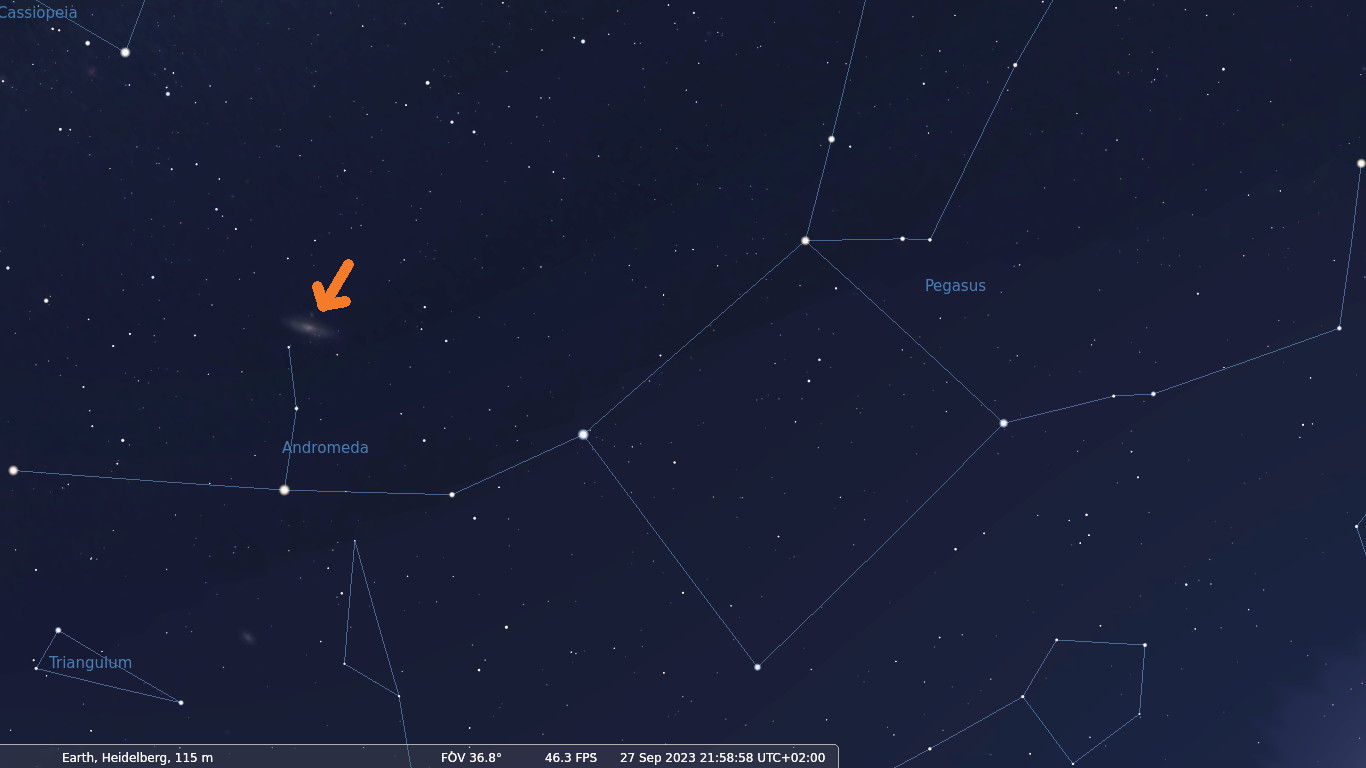

| [1] | Und dazu die, wie wir heute wissen, noch weit größeren Beiträge aus der Bewegung der Sonne um das Zentrum der Milchstraße, die Eigenbewegung der Milchstraße in der lokalen Gruppe und, ganz dramatisch, den Sturz der lokalen Gruppe Richtung Coma-Haufen. Aber von fast allem davon wusste mensch noch nichts in den Zeiten von Michelson und Morley Ende des 19. Jahrhunderts. Selbst die eher randständige Lage des Sonnensystems in der Milchstraße, die für die Bahnbewegung von rund 200 km/s sorgt (Bahngeschwindigkeit der Erde 30 km/s oder ein bisschen mehr als ein Zehntel, und wo wir schon dabei sind: Die Fluchtgeschwindigkeit der Erde ist ein bisschen mehr als 10 km/s), hat erst in den 1910er Jahren Harlow Shapley durch die Untersuchung der Verteilung der galaktischen Kugelsternhaufen wirklich überzeugend nachgewiesen. |

![[RSS]](../theme/image/rss.png)

![Ein fotografierter Text, in dem u.a. steht „die sogenannte Große Magellan'sche Wolke [...] und den Andromedanebel auf, zwei Galaxien des südlichen Sternenhimmels“](/media/2023/liebieghaus-andromedanebel.png)