Der Oliv-Index

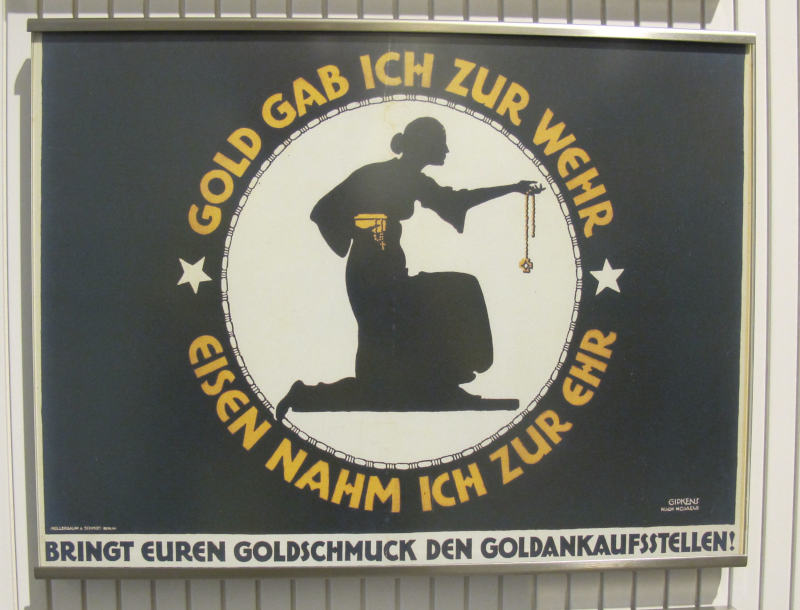

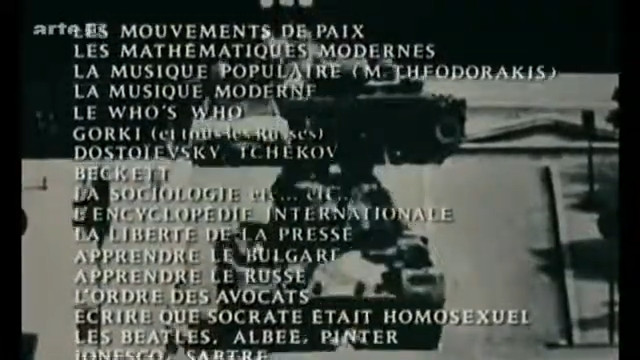

Die Staudte-Verfilmung von Klaus Manns Untertan (DDR 1951) illustriert die militarisierte Gesellschaft durch eine Revuenummer, in der Frauen mit Pickelhauben zu uniformiertem Gesang von der „Elite der Nation“ halb tanzen, halb marschieren. Olivindex: 1. (Rechte bei… na ja, wer immer den DEFA-Kram halt gekauft hat.)

Wer in den frühen 1990er Jahren Filme wie Der Untertan oder, etwas leichtherziger, den Hauptmann von Köpenick gesehen hat, wird die Verehrung des Militärischen, die dort gezeigt wurde, für eine unfassbare historische Verirrung gehalten haben, eine Art kollektive Psychose, lächerlich und zugleich gruselig, aber jedenfalls vom anderen Ende der Geschichte.

Dann kam die Zeitenwende; nicht etwa jetzt, sondern im Laufe der 1990er, in denen sich die Bundeswehr zurückrobbte an diverse Plätze an der Sonne, angefangen mit Jagdbombern, die im Januar 1991 US-Jets in der Türkei ersetzten, damit diese für die Wiedereinsetzung des Emirs von Kuwait töten konnten. Es folgten die ersten Truppen außerhalb des NATO-Gebiets in Kambodscha im Mai 1992, wo im Oktober 1993 auch der erste Held anfiel (for the record: Alexander Arndt), dann mit AWACS-Flügen über Jugoslawien und so weiter und so fort. Langsam, aber bestimmt überschritt das Militär immer wieder zuvor sicher geglaubte Grenzen. Der große Zusammenbruch, oder wegen mir die Zeitenwende, kam aber erst ganz am Ende der 1990er Jahre: Militärminister Rühe hatte noch 1997 verkündet, nie wieder dürfe ein Stiefel eines deutschen Soldaten in Jugoslawien auftreten. 1999 griff die Bundeswehr Serbien an und marschierte im Kosovo ein, geschmackloserweise gerade unter Verweis auf die Verbrechen der deutschen Großväter (die damals ja noch in großer Zahl lebten).

Nach diesem Tabubruch schlichen sich Reden von Helden, Tapferkeit und Vaterland in immer mehr Salons, kehrte der Glaube zurück, Militär an sich und schon gar deutsches Militär könne irgendwo und schon gar im Ausland Zustände verbessern. Mit der schon aus fünf Schritt Entfernung offensichtlich dystopischen Erzählung vom R2P wurde ab 2005 aus dem „Können“ allmählich ein „Müssen“ – also: dort, wo es bequem war und gegen die richtigen Feinde ging.

„Rohrkrepierer“ ist eine Diagnose – von Sprache

Die Militarisierung des Diskurses fand nicht nur nach außen statt. Eines der exteremen Beispiele: 2005 sollte die Bundeswehr für die Polizei Zivilflugzeuge abschießen dürfen – was das Verfassungsgericht 2006 zum Glück nochmal einfangen konnte (vgl. Luftsicherheitsgesetz in der Wikipedia). Dass der Corona-Krisenstab einen General als Vorsitzenden bekam, war kurzfristig ein neuer Höhepunkt der Preußen-Renaissance. Wieder half das Glück der Zivilgesellschaft, denn dieses Gremium stellte sich schnell als Rohrkrepierer (um mich auch kurz an Militärsprache zu versuchen) heraus.

Nach dem Umschlagen der jüngsten Aufrüstungsrunde (das verlinkte PDF ist von 2019; der Kram ist also nicht neu) in einen weiteren Krieg hat eine giftige Mischung aus Patriotismus und Militarismus wenigstens vorläufig die… unbestrittene Lufthoheit. Zeitweise waren und sind Kommentare, die sich positiv auf deutsche Eingriffe in Kriege bezogen, in der Presseschau im Deutschlandfunk in der breiten Mehrheit, während in der Tagesschau oft kaum ein Beitrag ohne Olivgrün daherkommt.

Ein Thermometer fürs Kriegsfieber

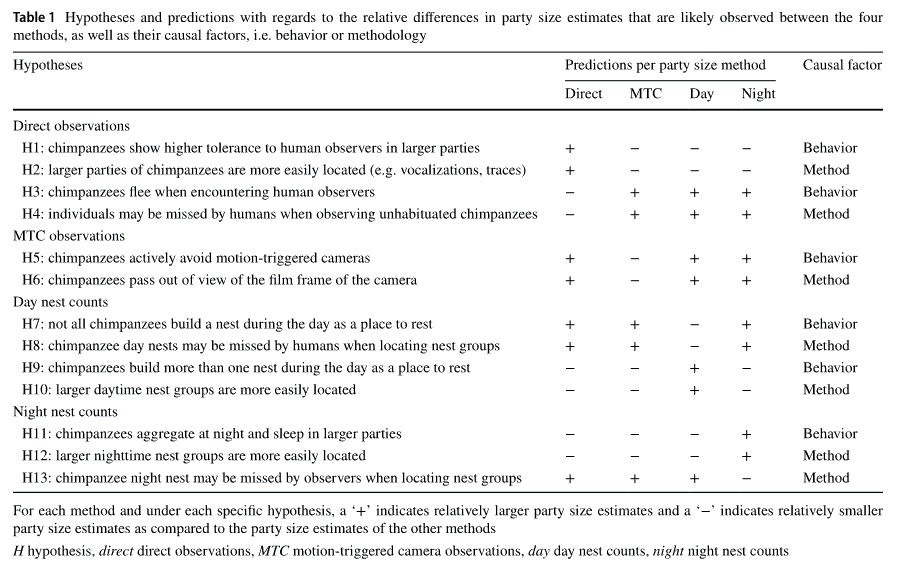

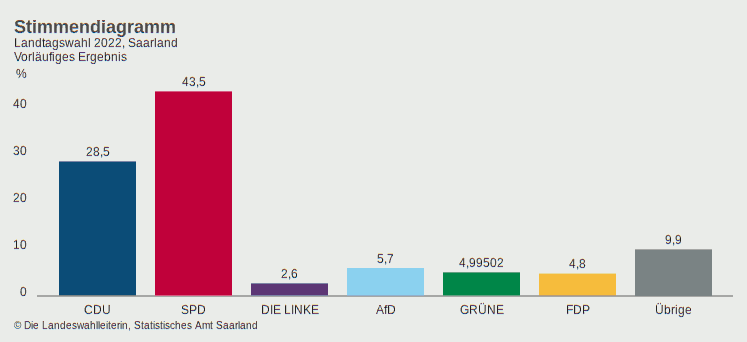

Auch ein erklärter Feind von Metriken wie ich kann an dieser Stelle nicht widerstehen. Es braucht eine Zahl zur Charakterisierung des gesellschaftlichen Kriegsfiebers[1]. Nun, hier ist meine Zahl: Der Oliv-Index. Der von heute ist 0.55, wobei 0 „alles zivil oder unpatriotisch“ und 1 „der Kaiser schickt seine Soldaten aus“ bedeutet. Etwas weniger blumig ist der Oliv-Index ist das Verhältnis der Zahl der patriotisch-militaristischen Kommentarauszüge zu allen, die an einem Tag in der Morgen-Presseschau des DLF zitiert werden.

Der Olivgrün-Index zwischen siebtem und 21. Mai: Je oliver, desto höher das patriotisch-militärische Fieber im Blätterwald der Republik.

Nachtrag (2022-06-09)

Ich führe den Olivindex tatsächlich fort, und für eine Weile ist die aktuelle Lage jeweils am Fuß der Blogseiten. Und, jeweils aktuell, solange ich das Elend auswerte, hier:

Ich habe das in den vergangenen zwei Wochen ausprobiert, schon, um zu sehen wie viele Zweifelsfälle es geben würde. Tatsächlich war es beispielsweise nicht immer einfach, die Kommentare zur Entthronung von Gerhard Schröder korrekt einzuordnen: Was davon war allgemeine patriotische Empörung, was davon Empörung über Vaterlandsverrat im Krieg? Und – nicht, dass das für den Oliv-Index eine Rolle spielen würde: Was war Abwiegelung aus Staatsraison, was Abwiegelung aus kühlem Kopf? Die naheliegende Position „wenn ihr ihn wegen Kosovo und Hartz IV, wegen Afghanistan und Riesterrente, wegen BamS und lupenreinen Demokraten nicht abgesägt habt, müsst ihr es jetzt auch nicht mehr machen“ kam leider nicht vor.

Dennoch sind Zweifelsfälle nach meinem ersten Eindruck nicht furchtbar dramatisch. Ich würde vermuten, dass andere Menschen meine Scores innerhalb von vielleicht 10% reproduzieren würden.

Wer das probieren will, ist herzlich eingeladen. Dazu könnt ihr meine codes.txt inspizieren und sehen, ob ihr meine Einschätzungen teilt, solange die Presseschauen nicht depubliziert sind (was derzeit leider sehr schnell geht). In so einem Code steht von links nach rechts jedes Zeichen für einen Kommentarauszug, von oben nach unten gelesen. Ein o steht für einen oliven, also patriotisch-militaristischen Artikel, ein Punkt für einen anderen.

Ihr könnt auch das Programm, das die Plots macht, ziehen: olivin. Da dürfte sich in der nächsten Zeit noch das eine oder andere ändern, denn, das gebe ich gleich mal zu, ich hoffe, am Schluss etwas Ähnliches zu produzieren wie die längst zu Popkultur gewordenen Climate Stripes von Ed Hawkins. Nur eben, ich bin ja Optimist, als Illustration einer vielleicht wieder allmählich sinkenden Begeisterung für Militär und Vaterland.

Nachtrag (2023-06-17)

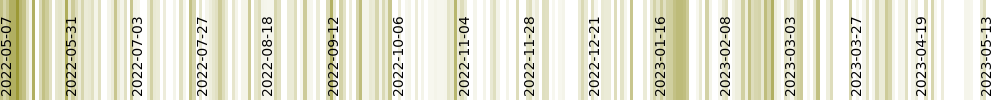

Nach über einem Jahr mit der DLF-Presseschau hat mich jetzt die Lust verlassen; die letzte Presseschau, die ich verdaut habe, ist die vom 20.5.2023. Hier sind die military stripes von damals:

Verschiedene braune Bänder lassen sich den Ereignissen der Zeit zuordnen; so entspricht das starke Feature rechts von 2023-01-16 der Großaufregung für die Lieferung von Kampfpanzern aus der Produktion der Rüstungsschmieden Krupp^W Krauss-Maffei-Wegmann und Rheinmetall an die Regierung der Ukraine; die darauf folgende weiße Beruhigung illustriert, dass der militärisch-patriotische Komplex durchaus auch mal für ein paar Tage zufrieden sein kann.

Aber erstens war die militärisch-patriotische Begeisterung schon im letzten Sommer insgesamt überschaubar, und zweitens artet das alles in Arbeit aus. Wenn aber wer mal mit inzwischen über einem Jahr DLF-Presseschauen spielen will (ich könnte mir z.B. vorstellen, dass ein darauf nachtrainiertes LLM ausgesprochen bizarre Sachen sagen würde), möge sich bei mir rühren.

| [1] | Nun ja: Für die Leute, die die Metriken definieren, sind sie ja schon nützlich, denn natürlich wird mensch die so definieren, dass sie den eigenen Interessen dienlich sind. Insofern bin ich natürlich kein Feind von Metriken, die ich definiere. |

![[RSS]](./theme/image/rss.png)