Ich war seit gestern in anderer Sache in Bonn, hatte dabei aber Zeit für

einen mittel-langen Blick in das „LVR LandesMuseum Bonn“. Das wollte

ich gerne, denn erstens wusste ich, dass dort die Überreste des

originalen Neandertalers liegen, und zweitens bin ich im Rahmen meines

Römerfimmels schon einige Male auf „Original im LVR LandesMuseum Bonn“

(oder diverse Varianten der flamboyanten Schreibweise)

gestolpert.

Tatsächlich habe ich von den Exponaten, die im Wikipedia-Artikel zum

Museum erwähnt sind, nicht viel gesehen, denn die Leute bauen gerade

eifrig um. Dafür bin ich aber auch umsonst reingekommen, und zumindest

der Ur-Neandertaler war am Platz – die gefundenen Knochen ebenso wie

eine rekonstruierte Figur.

Letztere hatte nichts mehr von den gebeugten, haarigen Kreaturen, die noch

vor wenigen Jahrzehnten das Neadertaler-Bild prägten. Der

Steinzeitspeer in der Hand musste jedoch offenbar noch sein, obwohl

doch Verbandszeug viel besser zur Befundlage passen würde. Der

Ur-Neandertaler hatte nämlich ausweislich der nachgebliebenen Knochen 20

Jahre vor seinem Tod eine ziemlich schwere Armverletzung, und dass er

danach so lange überlebt hat, wird als eindeutiger Beleg für

Krankenversorgung und Fürsorge unter NeandertalerInnen gewertet.

Eher noch beeindruckender fand ich aber die keltische Abteilung des

Museums, in der Folgendes ausgestellt ist:

Das ist nicht etwa ein Diorama des gallischen Dorfes von Asterix und

Obelix. Nein, es ist ein Diorama, das die archäologischen Erkentnisse

zum gallischen Dorf von Niederzier-Hambach reflektiert. Genauer war

dort eine eburonische Siedlung, die

(vermutlich) im Rahmen der caesar'schen Angriffskriege im östlichen

Gallien 54 bis 51 vdcE aufgegeben wurde.

Weil sie so prima in unsere Zeit passt, lasst mich kurz ein Destillat

dieser Geschichte im Geiste meiner Betrachtungen zu Chios erzählen:

Um 57 vdcE ließen die eburonischen Herrscher ihre Untertanen mit Caesars

Truppen Belger abmetzeln. Doch schon zwei Jahre später empfanden sie

das römische Winterlager irgendwo in der Nähe ihrer Hauptstadt

(„Atuatuca“; kein Mensch weiß heute mehr, wo das überhaupt war) als

unerträgliche Kränkung nationaler Gefühle. Sie brachten also die Römer

irgendwie dazu, aus ihrem Kastell auszurücken. Als sie das geschafft

hatten, ließen sie ihr Militär angreifen, das, so Caesar, 10'000

römische Soldaten umbrachte.

Die, ach ja, „Offensive“ erwies sich mittelfristig als unklug, denn

Caesar konnte sowas nicht auf sich sitzen lassen. Er selbst bezichtigt

sich im de bello gallico des, ach ja, „Genozids“. In den aktuellen

Worten der Wikipedia:

Die Einwohner wurden niedergemetzelt, die Gehöfte

eingeäschert, das Vieh weggetrieben. König Catuvolcus starb durch

Suizid (53 v. Chr.), König Ambiorix konnte mit knapper Not über den

Rhein zu den Germanen entkommen. Über sein weiteres Schicksal ist

nichts bekannt. Archäologisch lässt sich für die Zeit um 50 v. Chr. in

eburonischen Siedlungen tatsächlich oftmals ein Siedlungsabbruch

erkennen.

Auch in der Darstellung im Landesmuseum werden Zweifel geäußert, ob nun

die Römer die EburonInnen wirklich alle abgemurkst haben; der gute

Zustand der Reste von Niederzier-Hambach und auch das Fehlen eines

Brandhorizonts lassen vermuten, dass hinreichend viele EburonInnen klug

genug waren, sich auf keine weiteren Kriegshandlungen einzulassen und

schlicht davongerannt sind. Etwas in dieser Art schlägt auch der

Bericht von Strabo vor, der so um die christliche Epoche herum von den

Eburonen wieder als Verbündete Roms spricht. Dennoch:

Bioarchäologisch ist nachweisbar, dass nach den römischen Feldzügen der

Wald das eburonische Land zurückgewann. Oh Grusel.

Wo gerade die Rede von Ambiorix war: Nicht nur die gallischen Dörfer

sehen offenbar so aus wie halt gallische Dörfer, also die bei Uderzo und

Goscinny. Die Leute scheinen auch so zu heißen. Ambiorix,

Vercingetorix, Verleihnix. Im Landesmuseum gab es dazu eine These, die

ich, so glaube ich, zuvor noch nicht gehört habe. Und zwar sei die

Namensendung -rix eigentlich ein -rigs, was wiederum mit dem

lateinischen Rex, König zu vergleichen sei. Ambiorix sei dann also

„König der Ambiorer“, Asterix vielleicht „König der Sterne“. Obelix…

oh, nee, ich mache jetzt keine Witze über mögliche Sprachfehler.

Nach dieser Deutung kämen die zahlreichen auf -rix endenden Namen in der

Überlieferung einfach daher, dass die klassische Geschichtswissenschaft

im Wesentlichen von Königen und ihren Untergrobianen redet. Mir

hingegen ist viel sympathischer der relativ neue Trend (ich linke dazu

auf Arno Borst, 1925-2007) der Archäologie, das wirkliche Leben zu

betrachten. Dabei können so (mich) verblüffende Ergebnisse herauskommen

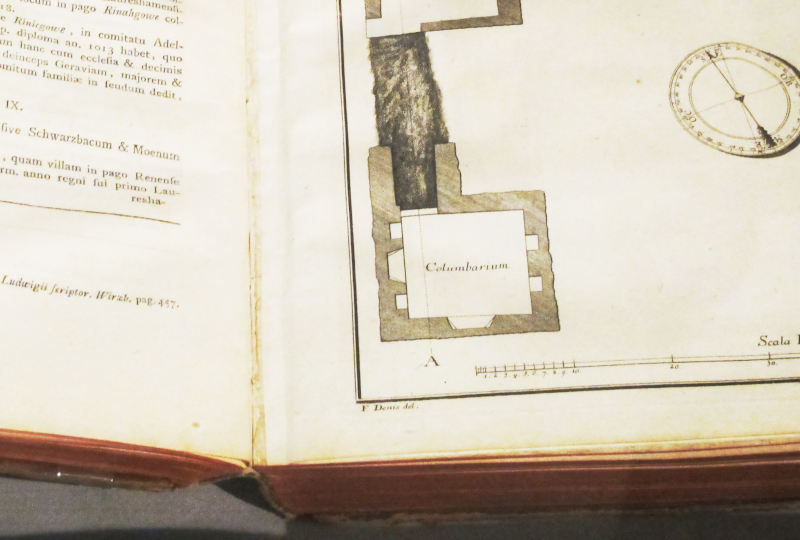

wie: Die Römer hatten Klappmesser. Nehmt etwa dieses her:

Das ist ein Fund aus dem Grab der „Schönen von Zülpich“, und die

MuseumskuratorInnen wundern sich ein wenig, was wohl so ein Taschenmesser

in einem Frauengrab macht. Ein wenig sexistisch fand ich das schon, in

jeder Richtung; denn soweit ich das sehe – die Römer haben ihre Toten ja

bis zur christlichen Machtübernahme durchweg verbrannt, so dass es kaum

DNA-Evidenz geben wird –, wird die These des Frauengrabes im

Wesentlichen nur durch Beigaben von Spiegel, Kamm und Cremes gestützt,

die zumindest ausgehend vom modernen Befund durchaus auch von Männern

genutzt werden.

Und selbst wenn die Tote weiblich war, sind Taschenmesser wirklich recht

unabhängig von Geschlechtszuschreibungen nützlich; stellt euch alleine

mal vor, wie lausig die kaum gezüchteten Orangen der römischen Zeit zu

schälen gewesen sein werden. Nur, weil unser Patriarchat

Frauen Klappmesser lieber vorenthält (schon dadurch, dass Frauenkleidung

wenigstens vor dem Zeitalter großer Telefone meist keine

messergeeigneten Taschen hatte), heißt das ja noch nicht, dass das

römische Patriarchat das auch so gehalten hat.

Jedenfalls: Dann und wann bin auch ich noch überrascht über den Stand

der Technik in den römischen Provinzen. Das gilt vielleicht noch mehr

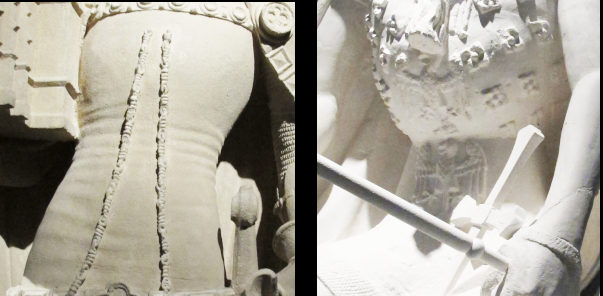

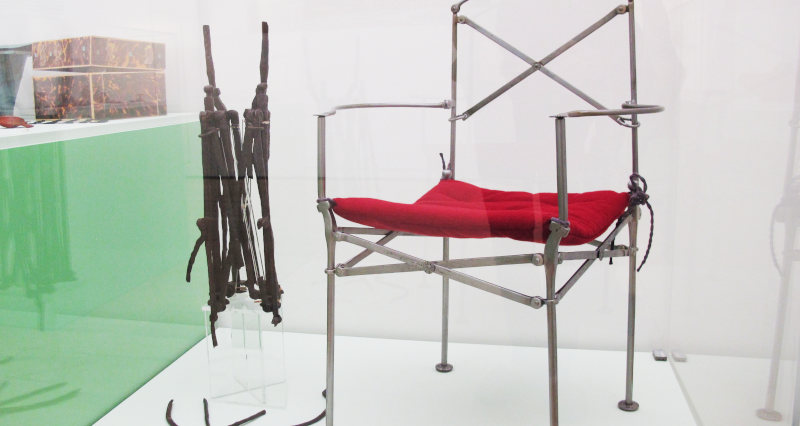

für den Klappstuhl der „Priesterin von Borschemich“:

Das rostige Zeug links ist in einem Grab einer Anhängerin, vielleicht

sogar einer Priesterin, einer der zahlreichen orientaloiden Kulte des

kaiserzeitlichen Roms gefunden worden, und die Museumsleute haben mich

davon überzeugt, dass das schicke Teil rechts eine zuverlässige

Rekonstruktion des Originalzustands ist; wer vor Ort ist und das rostige

Zeug genauer ansieht, dürfte, so erwarte ich, diese Einschätzung

schließlich teilen.

TIL: Die Römer hatten Campingmöbel. Vielleicht haben sie die zu

kultischen Zwecken eingesetzt, aber vielleicht ist das bei uns auch

nicht so viel anders.

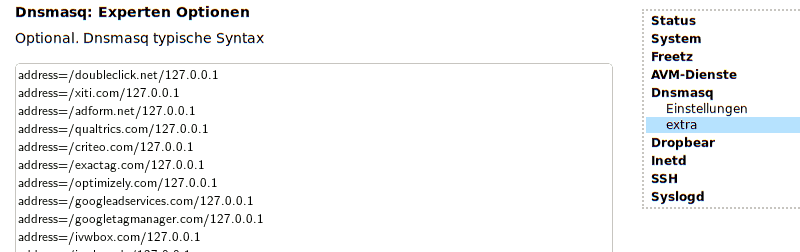

Zum Schluss muss ich etwas besorgte Kritik loswerden, und zwar an diesem

Ausschnitt aus dem „Stammbusch“ des Menschen, der in der Nähe des

Neandertalers zu finden ist:

Zunächst ist das schon ein wenig moderner als die

Anno-Darwin-Anthropologie, denn die verschiedenen Homo-Arten mischen

sich in diesem Bild zum modernen Menschen (der durchgezogene senkrechte

Strich ganz rechts), und der Neandertaler steht nicht mehr als tumber,

unterlegener, rausdarwinierter, toter Ast da. Das ist schön.

Zumindest in eine möglicherweise nicht so schöne Ecke geht das

allerdings im breiteren Kontext. Auf der grauen, oberen Fläche steht

nämlich außerhalb des gewählten Ausschnitts „Europa“, auf der unteren,

blasstürkisen „Afrika“. Und so könnten Menschen das als Teilrevision

der in konservativen Kreisen immer noch gerne als kränkend empfundenen

Out of Africa-Theorie ansehen. Jaja, so könnte mensch hier lesen,

Homo sapiens ist schon in Afrika entstanden, aber zum ordentlichen Homo

sapiens sapiens ist er erst geworden, als er es nach Europa geschafft

hat und dort dem hellhäutigen Neandertaler zum letzten Schliff verholfen

hat. Wenn das die Intention dieser Grafik sein sollte, würde ich

erstmal (also: bis irgendwer sehr starke Belege bringt, dass die Homo

sapiens, die seinerzeit aus Afrika ausgerückt sind, nicht schon fertige

moderne Menschen waren) sagen: Nicht so schön.

Die beeindruckende Animation der Ausbreitung der verschiedenen

Homo- und Australopithecus-Arten während der vergangnen paar Millionen

Jahre, die rechts von diesem Stammgebüsch an der Rückwand der

Neandertaler-Halle läuft, gibt das dicke Linie-dünne Linie-Verhältnis in

dieser Darstellung ebenfalls überhaupt nicht her. Dort ist pures Out

of Africa zu sehen. Tatsächlich besiedeln (erobern?) in deren

Darstellung moderne Menschen West-, Süd- und Ostasien, lange bevor sie

sich ins kalte Europa wagen.

Dennoch: das Landesmuesum in Bonn kann ich warm empfehlen, auch während

der Umbauarbeiten. Ob mensch danach noch ohne Geld zumindest in die

Dauerausstellung kommt: Das hätte ich wohl erfragen sollen. Habe ich

aber nicht gemacht.

![[RSS]](./theme/image/rss.png)