Antisprache: Arbeitsplätze

Unter all den eigenartigen Ritualen des politischen Diskurses verwundert mich so ziemlich am meisten, dass „gefährdet Arbeitsplätze“ fast universell als Argument gegen eine Maßnahme, als ultimativer Warnruf gilt. Lasst mich einige der befremdlicheren Zitate den DLF-Presseschauen des vergangenen Jahres anführen:

…ganze Branchen wegen ihres hohen Gasverbrauchs in Existenznot, tausende Arbeitsplätze stehen auf dem Spiel.

—Rheinische Post (2022-10-11)

In diesem Sinne ist es ein Ansporn, schnell gute, neue Produkte zu entwickeln, die den großen Teil der Arbeitsplätze sichern.

—Badische Zeitung (2023-02-15)

Die Politik muss aufpassen, dass sie nicht deutsche Arbeitsplätze opfert…

—Reutlinger General-Anzeiger (2023-02-15)

…wie einst bei der Solarbranche der Ausverkauf der deutschen Wärmepumpenindustrie bevorsteht und Arbeitsplätze sowie hoch spezialisiertes Wissen abwandern.

—Rhein-Zeitung (2023-04-27)

Was da in einen negativen Kontext gestellt wird, ist nüchtern betrachtet: Leute müssten weniger arbeiten, und das meist ohne erkennbar negative Folgen. Ist das nicht ganz offensichtlich eine gute Sache?

Es schimpfen doch fast alle Menschen mehr oder weniger deutlich über ihre Lohnarbeit, oder? Obendrauf habe ich schon zu oft gehört, Leute würden ja den Rest der Welt schon gerne vor ihrem Auto verschonen, aber die Lohnarbeit zwinge sie, sich jeden Morgen in ihren Blechkäfig zu setzen. Und das muss dringend geschützt und gehegt werden?

Obendrauf gibts allerlei Wunder, die Arbeit sparen: Staubsaug- und Rasenmähroboter, Lieferdienste und vielleicht irgendwelche Apps. Die wiederum gelten als „Innovation“ und damit irgendwie gut (mehr Antisprache dahingestellt). Wie geht es zusammen, dass einerseits Leute weniger arbeiten möchten, andererseits aber Möglichkeiten, wie sie weniger arbeiten könnten, an Bedrohlichkeit über dem Weltuntergang stehen („Klimaschutz darf keine Arbeitsplätze kosten”, „Vereinbarkeit von Ökonomie und Ökologie“)?

Ein Minimum an Lohnarbeit

Die Antwort: Gar nicht. „Arbeitsplatz“ ist ein klassischer Fall von Antisprache, also Wörtern und Phrasen, die Information nicht übertragen, sondern annihilieren. Der Antisprache von den Arbeitsplätzen gelingt es, die Information zu annihilieren, dass wir längst die Technologie und wahrscheinlich auch die soziale Reife hätten, um allen Menschen mit einem Minimum an Lohnarbeit[1] ein ökologisch vertretbares Leben ohne Existenzsorgen zu ermöglichen. Dass der Lebensunterhalt an „Arbeitsplätze“ gebunden ist, ist mithin eine überflüssige, grausame und gefährliche Konvention, die durch ehrlichere Wortwahl sichtbar gemacht werden könnte.

Ein „Minimum an Lohnarbeit“ hat übrigens fast nichts mit der drei- oder vier-Tage-Woche zu tun, die die taz gestern mal wieder erwähnt hat, denn diese bleibt dem alten Mechanismus des Kapitalismus verhaftet. Dabei werden Waren produziert oder Dienstleistungen erbracht, weil manche Leute („Unternehmer“) reich werden wollen und nicht etwa, weil Menschen sie brauchen und das Zeug nicht allzu schädlich ist. So kommt es, dass wir schockierende Mengen von Arbeitskraft und Natur verschwenden auf jedenfalls gesamtgesellschaftlich schädliche Dinge wie Autos, andere Waffen, Einfamilienhäuser, fast fashion, Zwangsbeflimmerung und das rasende Umherdüsen in überengen fliegenden Röhren.

Es ist die Konvention, Menschen durch Drohung mit dem Entzug ihres Lebensunterhalts[2] dazu zu zwingen, all den unsinnigen Krempel herzustellen, die auch dafür sorgt, dass „wir“ uns eine überflüssige Lohnarbeit nach der anderen einfallen lassen. Meist sind das „Dienstleistungen“ (auch so ein schlimmes Wort), was dann immerhin manchmal nicht ganz so schädlich ist wie der ganze überflüssige Quatsch (Autobahnen, Konferenzzentren, Ultra-HD-Glotzen) auf der Produktionsseite[3].

Ein eher harmloser Nebeneffekt des Ganzen beschäftigte übrigens Casper Dohmen und Hans-Günther Kellner im Deutschlandfunk-Hintergrund vom 23.6., der sich ebenfalls an weniger Arbeit trotz Kapitalismus abarbeitete:

In den neunziger Jahren betrug die Produktivitätssteigerung in Deutschland im Schnitt noch mehr als zwei Prozent jährlich, seitdem weniger als ein Prozent. Die Entwicklung ist typisch für hoch entwickelte Industriestaaten. Das liegt daran, dass es schon länger keine wesentlichen Innovationen gab, mit denen sich die Produktivität erhöhen ließe.

Schon die Antisprache von den „Innovationen“ lässt ahnen, dass das in der ganz falschen Richtung sucht – auch wenn das Rationalisierungspotenzial durch Rechner im Bürobereich tatsächlich drastisch überschätzt ist (Bob Solow: „You can see computers everywhere except in the productivity statistics“).

Aber den eigentlich notwendigen Kram kriegen wir mit wirklich beeindruckend wenig menschlichem Aufwand und also atemberaubender Produktivität hergestellt. Letztes Wochenende etwa hat ein Mensch das Getreidefeld neben meinem Gärtchen (grob „ein Morgen“ oder ein halber Hektar) in der Zeit abgeerntet, in der ich fünf Codezeilen geschrieben habe. Natürlich muss mensch noch die Arbeitszeit dazurechnen, die im Mähdrescher und dessen Sprit steckt, aber auch die wird sich, auf die Flächen umgelegt, die mit der Maschine bearbeitet werden, zwanglos in Minuten messen lassen.

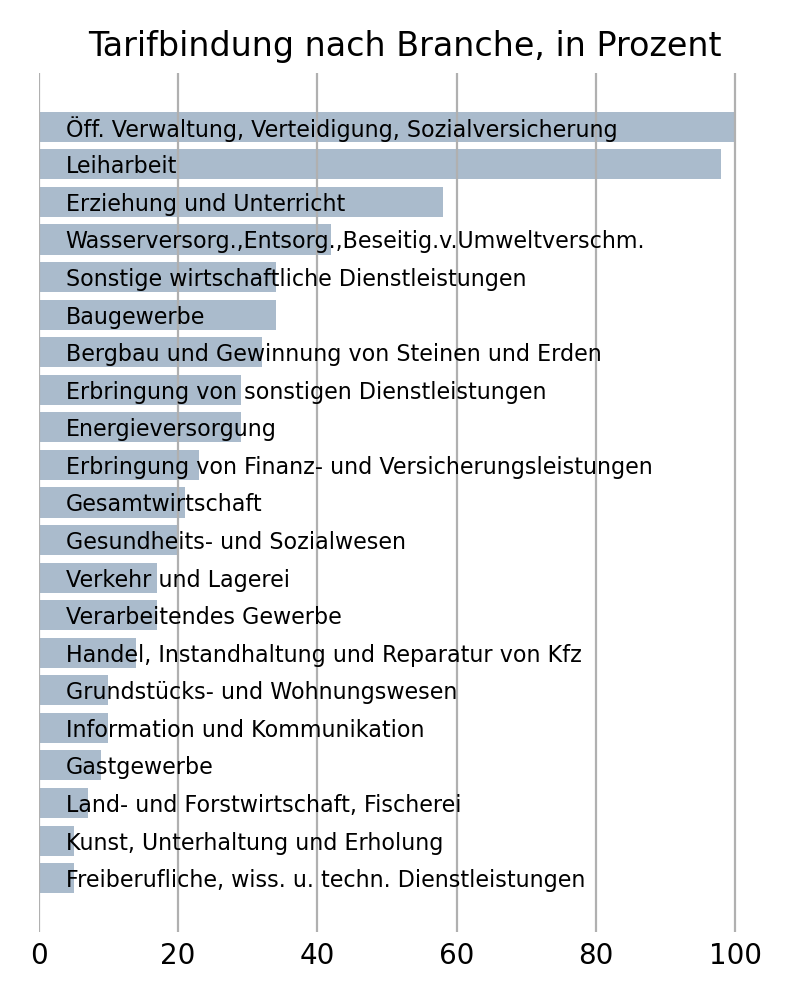

Nein, der Grund für die mehr oder minder stagnierende Produktivität der Gesamtgesellschaft (kurzerhand definiert als Bruttoinlandsprodukt pro Arbeitsstunde) ist die Ausweitung des Niedriglohn-Sektors, sind Jobs wie Lieferdienste, „Juicer“ (dass Menschen für sowas Lebenszeit opfern müssen, beschämt mich zutiefst), Wachdienste, also das gesamte Jobwunder im Gefolge von Hartz IV: Wer für eine Handvoll Euro viele Stunden arbeiten muss, senkt natürlich den Durchschnitt von BIP/Zeit, und wenn das erschreckend viele sind, wird das auch nicht mehr von den paar Leuten mit Salären im 104 Euro/Stunde-Bereich ausgeglichen[4]. So erklärt sich übrigens das „neunziger Jahre“ versus „seitdem“ aus dem DLF-Beitrag ganz natürlich: Die Schröder-Regierung hat die Hartzerei zwischen 2002 und 2005 eingephast.

Es sind also gerade all die „Innovationen“ vom Schlage zu juicender Elektroroller, die die Produktivität drücken. Natürlich wird das nichts mit BIP/Arbeitsstunde, wenn ein wesentlicher Teil der Menschen in privatwirtschaftlichen Arbeitsbeschaffungsmaßnahmen stecken, für die jetzt wirklich niemand viel Geld bezahlen will.

In Klarsprache übersetzt

Wozu also führen wir die Tragikomödie mit dem Lohnarbeitszwang auf? Sachlich, damit sich ein paar Grobiane gut fühlen, weil das Bruttoinlandsprodukt ihres Landes steigt, und ein paar andere, weil ihr Kontostand wieder ein paar Milliarden ihrer bevorzugten Währung mehr zeigt.

Letzteres ist wiederum besonders verdreht, denn so viel Geld könnten diese Leute nie für tatsächliche Waren ausgeben, schon, weil es gar nicht so viel zu kaufen gibt außerhalb von mondbepreisten Kunstwerken, Aktien und Immobilien, deren Kosten in überhaupt keinem Verhältnis mehr stehen zur in ihnen vergegenständlichten Arbeit.

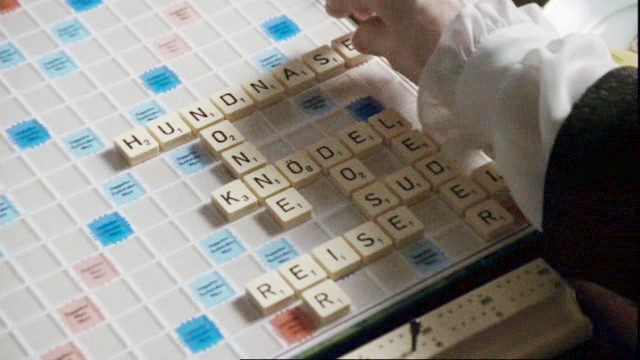

Die Antisprache von den Arbeitsplätzen wirft in Summe einen dicken Nebel rund um etwas, das schlicht ein hässliches Erbe der trüben Verangenheit ist. Wie so oft bei Antisprache lichtet sich der Nebel um groteske Sachverhalte schon, wenn mensch einfach die Antisprache ersetzt durch Wörter mit der jeweils zutreffenden Bedeutung. Ich habe das mal mit ein paar der Presseschau-Texte gemacht:

In diesem Sinne ist es ein Ansporn, schnell gute, neue Produkte zu entwickeln, die viel Arbeit machen.

—nicht Badische Zeitung (2023-02-15)

…wie einst bei der Solarbranche der Ausverkauf der deutschen Wärmepumpenindustrie bevorsteht und sich danach andere Menschen als wir plagen müssen sowie hoch spezialisiertes Wissen abwandert.

—nicht Rhein-Zeitung (2023-04-27)

Die beiden Zitate könnt ihr im Original oben nachlesen. Vergleicht mal. Und dann ratet, wie die folgenden Zitate wohl wirklich ausgesehen haben werden:

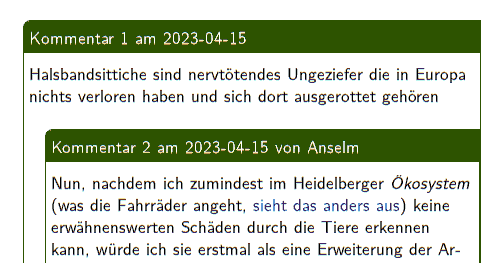

Kein Wunder, dass die Bevölkerung allmählich Existenzängste bekommt, wenn Heizen unbezahlbar zu werden droht und sie dann auch noch frei bekommen könnten.

—nicht Dithmarscher Landeszeitung (2022-09-02)

Entscheidend ist, alles zu tun, dass alle arbeitsfähigen Menschen auch arbeiten müssen und es sich lohnt zu arbeiten.

—nicht Mediengruppe Bayern (2022-11-23)

Vielleicht bietet der jetzige Kahlschlag [bei Karstadt], der erneut Tausende Mitarbeiter von stupider Arbeit an der Kasse und im Lager erlöst und daher äußerst bitter ist, die Chance auf ein Gesundschrumpfen.

—nicht Badische Zeitung (2023-03-14)

Menschlich ist es verständlich, dass auch Politiker eine möglichst angenehme Atmosphäre schätzen, wenn sie sich schon plagen müssen.

—nicht Schwäbische Zeitung (2023-05-04)

Nur, falls sich wer schlimm ärgert über diese Klarstellungen: Ja, mir ist klar, dass es unter den Bedingungen des Lohnarbeitszwangs jedenfalls sozial und möglicherweise auch materiell wirklich bitter ist, gefeuert zu werden.

Aber es hilft ja nichts: wir müssen uns so oder so um den Übergang in eine Gesellschaft kümmern, die maximale Existenzsicherheit mit minimaler Belastung für Menschen (also vor allem: Arbeit) und Umwelt (also vor allem: Dreck) zusammenbringt, und das bei maximaler Partizipation bei der Aushandlung dessen, was „Existenz” eigentlich bedeutet. Das Gerede von Arbeitsplätzen steht dem klar im Weg, schon, weil es den Betroffenen Willen und Möglichkeit raubt, zu diesem Übergang beizutragen.

Unterdessen verspreche ich, gelegentlich Constanze Kurz' Beitrag zu dieser Debatte zu lesen. Dass der jetzt auch schon zehn Jahre alt ist und die Presseschau immer noch voll ist mit Arbeitsplatzprosa, illustriert mal wieder, dass mensch bei der Verbesserung der Gesellschaft langen Atem braucht.

| [1] | Gleich vorneweg: In vernünftigen Szenarien ist „Lohnarbeit“ kein sehr nützlicher Begriff. Die bessere Rede von „gesellschaftlich notwendiger Arbeit“ würde aber sicher auch Kram umfassen, der im Augenblick massiv nicht durch Lohnarbeit abgedeckt wird, ganz vorneweg Reproduktion oder etwas moderner Care-Arbeit. Insofern ist die Schätzung der Fünf-Stunden-Woche (die im aktuell lohnarbeitigen Sektor über die Lebenszeit integriert und für eine global vertretbare Produktion wohl schon realistisch wäre) so irreführend, dass ich sie im Haupttext nicht erwähne. |

| [2] | Ich kann nicht anders: Auch das ist ein Beispiel dafür, wie unsere Vorfahren einer autoritären Versuchung nachgegeben haben: Statt Menschen zu überzeugen, dass eine Arbeit gemacht werden soll oder muss, haben sie diese durch Drohung mit Hunger oder Erfrieren zur Arbeit gezwungen. Einfach, aber mit schlimmen Konsequenzen, wie wir nicht nur auf unseren Straßen sehen. |

| [3] | Es gibt aber auch Beispiele für extrem schädliche Arbeitsplätze im Dienstleistungssektor. Beispielsweise hat die Finanzbranche ganz verheerende reale Auswirkungen (ein hübsches Stück Mainstream-Literatur dazu ist “Eine Billion Dollar“ von Andreas Eschbach … |

![[RSS]](./theme/image/rss.png)

![Foto eines weißen Textes auf schwarzem Grund: „Die Verwendung farbiger Truppen niederster Kultur als Aufseher über eine Bevölkerung von der hohen geistigen und wirtschaftlichen Bedeutung der Rheinländer [ist] eine herausfordernde Verletzung der Gesetze europäischer Zivilisation“ (Friedrich Ebert, 13.2.1923)](/media/2023/ebert-kolonialtruppen.jpeg)

![Screenshot der Bahnseite mit einer Meldung „Zum XX.XX.XXX werden die technischen Systeme von bahn.de umgestellt [...] Mehr Informationen finden Sie unter d2.](/media/2023/bahn-de-2023-06-11.png)