Trifft die Menschen hart

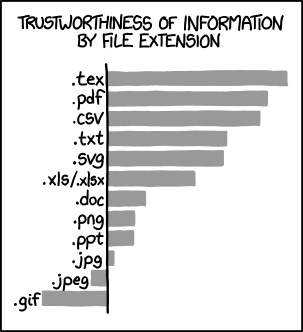

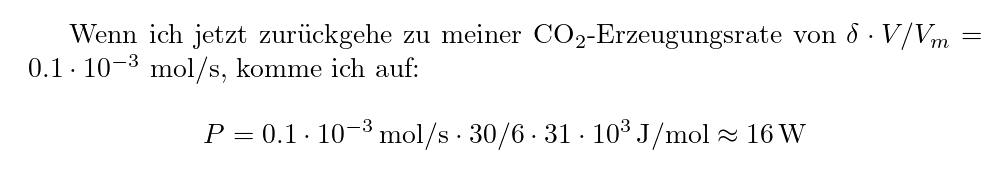

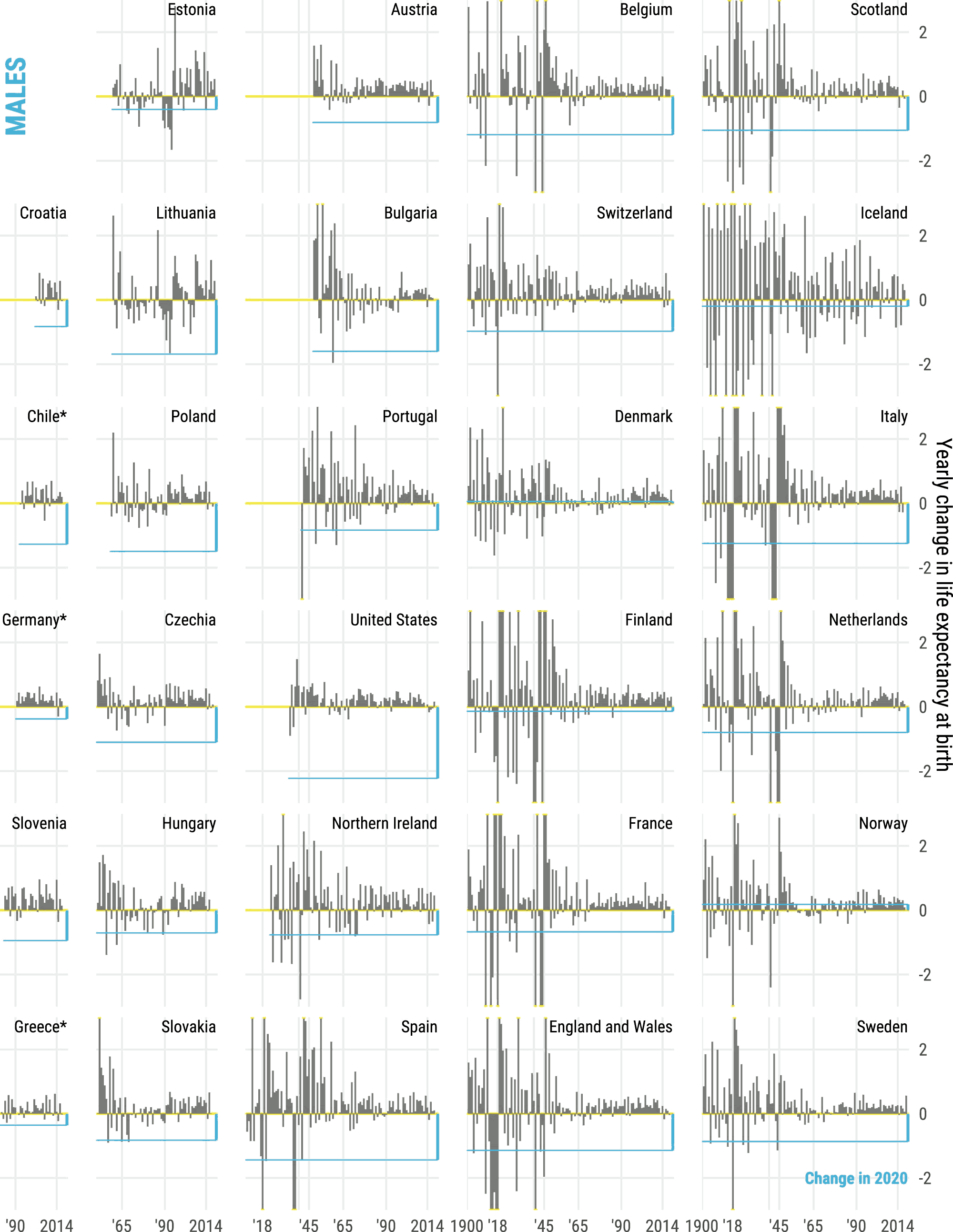

Die SARS-2-Pandemie ist historisch: relative Änderungen der Lebenserwartungen nach Jahren für Männer, soweit doi:10.1016/S2214-109X(21)00386-7 brauchbare Daten hatte. In Blau ist die Veränderung 2020 (also vor allem durch SARS-2) markiert. Es lohnt sich, die Abbildung detailliert in einem eigenen Browserfenster anzusehen: Von den demographischen Folgen des Zusammenbruchs der alten Ordnung in vielen Ex-Ostblockstaaten über die Spanische Grippe und die verschiedenen Kriege bis hin zum Rauschen der kleinen Zahlen in Island ist viel zu entdecken. CC-BY Aburto et al.

In den Informationen am Morgen im Deutschlandfunk hat der Moderator Rainer Brandes heute berichtet, dass die deutsche Regierung nun Einreisesperren für Menschen aus dem südlichen Afrika verhängt hat und fuhr fort mit dem Satz: „Das trifft die Menschen dort natürlich hart“.

Wenn das ein Versuch von Empathie war, ist der ziemlich misslungen. Einerseits, weil „die Menschen“ in der Region im Schnitt sicher nicht gerade jetzt (es ist eiskalt!) dringend in die BRD wollen. Tatsächlich wäre ich überrascht, wenn das Land als Reise- oder Fluchtdestination überhaupt schon in vielen Köpfen aufgetaucht wäre, schon aus Sprachgründen.

Weiter geht aus der Übersicht zur Visumspflicht des Auswärtigen Amts hervor, dass die BewohnerInnen aller Staaten des südlichen Afrikas (Südafrika/Azania, Eswatini, Lesotho, Simbabwe, Botsuana, Angola, Mosambik und sogar die unseres alten Schlachtfeldes Namibia) ohne Visum nicht reinkommen. Wie groß sind wohl die Chancen eines Durchschnittsmenschen aus, sagen wir, Namibia ohne bereits bestehende Kontakte hierher, so ein Visum zu bekommen?

Der wirklich wesentliche Punkt in Sachen Empathie ist aber: Für fast die gesamte EinwohnerInnenschaft des südlichen Afrika stellt sich die Visafrage nicht, und auch nicht die coronabedingter Reisebeschränkungen: Die Leute sind schlicht zu arm, und bevor sie darüber nachdenken, wo sie nächste Woche hinfliegen könnten[1], müssen sie erstmal klarkriegen, was sie morgen zu beißen haben.

Angesichts der oft wirklich schreienden Armut in der weiteren Region (und auch unserer eigenen Visapolitiken) ausgerechnet die coronabedinge Einreisesperre in die BRD als „hart“ zu bezeichnen – nun, das ist entweder verwegen oder ignorant.

Etwas Ähnliches ist mir neulich beim Hören eines Interviews mit Arne

Kroidl vom Tropeninstitut der

GSU

LMU München zu einer Corona-Seroprävalenzstudie in Äthiopien durch den

Kopf gegangen. Hintergrund ist das Paper

doi:10.1016/S2214-109X(21)00386-7, in dem berichtet wird, dass es

zwischen August 2020 und und Februar 2021 im eher ländlich geprägten

Jimma Inzidenzen im Bereich von im Schnitt 1600/100000/Woche gegeben

haben muss, in Addis Abeba sogar über 4500; was das für Inzidenzen

während der tatsächlichen Ausbrüche bedeutet, ist unschwer vorstellbar.

Das ist dort offenbar nicht besonders aufgefallen, es hat ein Forschungsprojekt gebraucht, um es zu merken. In einer im Wesentlichen völlig ungeimpften Bevölkerung.

Das ist kein Argument dafür, dass SARS-2 doch harmlos ist. Es ist ein Symptom der Nonchalance, mit der „wir“ Verhältnisse hinnehmen, in denen Menschen an einem Fleck recht normal finden, was woanders (zu recht) als wirklich ganz schlimme Gesundheitskrise empfunden würde. Bei aller Reserviertheit gegenüber Metriken und Zweifeln am Meldewesen: Laut CIA World Factbook ist die Lebenserwartung in Äthiopien 68 Jahre. Die Vergleichszahl für die BRD sind 81 Jahre.

Aburto et al, doi:10.1093/ije/dyab207, schätzen, dass Corona, wo es wirklich schlimm durchgelaufen ist (Spanien, Belgien), etwa anderthalb Jahre Lebenserwartung gekostet hat (in der BRD: ca. 6 Monate). Wie viel schlimmer das ohne Lockdown geworden wäre, ist natürlich Spekulation, aber da es gerade die besonders verwundbaren Bevölkerungsgruppen ohnehin besonders schlimm erwischt hat, dürfte ein Faktor fünf zwischen dem realen Verlauf und dem schlimmsten Szenario eine sehr plausible Obergrenze geben, oder etwa eine um acht Jahre reduzierte Lebenserwartung. Auch damit wäre die BRD immer noch fünf Jahre über den offiziösen Zehlen in Äthiopien.

Was in dieser Metrik[2] hier im Land ein unvorstellbares Gemetzel ist (denn fünf Mal Belgien wäre hier bundesweit Bergamo), ist dort Normalzustand, und zwar zu guten Stücken aus völlig vermeidbaren Gründen, wie beispielsweise unserer Völlerei; vgl. dazu How food and water are driving a 21st-century African land grab aus dem Guardian von 2010. Oder den IWF-Strukturanpassungsmaßnahmen, die, wo immer sie zuschlugen, das öffentliche Gesundheitswesen ruinierten und die Menschen Evangelikalen und anderen Hexendoktoren in die Arme trieben. Am Beispiel Peru illustriert zwangen „wir“ mit unseren marktradikalen Zivilreligion zwischen 1981 und 1990 die dortige Regierung zur Senkung der Gesundheitsausgaben um 75%.

Verglichen mit solchen Totalabrissen sind unsere Gesundheitsreformen kaum mehr als das Niederlegen einer Hälfte der Doppelgarage vor der Villa. Dass „wir“ bei sowas dezent in die andere Richtung schauen, das ist ein noch größeres Empathieversagen als das vom Anfang dieses Posts.

Nachtrag (2022-03-28)

Der Hintergrund Politik vom 11. März wirft weitere Blicke auf die SARS-2-Situation in Afrika. In der Sendung berichtet Kondwani Jambo beispielsweise, dass BlutspenderInnen in Malawi im Februar 2022 bereits zu 80% SARS-2-positiv waren; auch in einem Land mit einem – laut Angaben der Sendung – Durchschnittsalter von knapp 18 hätte eine derart hohe Welle eigentlich stark auffallen müssen. Die Vermutung, Kreuzimmunitäten mit lokal verbreiteten anderen Coronavieren könnten geholfen haben, findet Jambo nicht bestätigt. Seine in der Sendung unverbindlich angebotene Erklärung über „schnellere“ Monozyten in Malawi gegenüber einer britischen Vergleichsgruppe finde ich allerdings spontan auch nicht allzu überzeugend.

| [1] | Wie der BUND nicht ganz unplausibel behauptet: 90 Prozent der Weltbevölkerung haben noch nie ein Flugzeug von innen gesehen. |

| [2] | Wie immer sollte die Metrik nicht überbewertet werden; metriktheoretisch lesenswert ist in diesem Zusammenhang das Methoden-Kapitel der Aburto-Arbeit. Mensch sollte insbesondere klar haben, dass sich ein Tod weniger junger Menschen in der Lebenserwartung bei Geburt nicht von einem Tod vieler alter Menschen (wie bei SARS-2, wo der Verlust von Lebenserwartung bei Männern bei Aburto et al fast überall durch Tode in der Altersgruppe 60-79 dominiert ist) unterscheiden lässt. Mensch muss nicht Boris Palmer sein, um zwischen diesen Situationen unterscheiden zu wollen. Aber schon meine Erfahrungen mit Notaufnahmen in den USA (näher bin ich, eingestandenermaßen, Krankenhäusern im globalen Süden nie gekommen) sagen mir, dass die Lebenserwartungs-Zahlen eben doch oft sehr konkrete Not beim Zugang zu medizinischer Versorgung spiegeln. |

![[RSS]](./theme/image/rss.png)