Wahlen und Informationstheorie

Ich hatte neulich versprochen, ein paar Worte zu Zweifeln am repräsentativen Modell zu sagen, die sich aus der Informationstheorie speisen. Dazu braucht es zunächst einen Begriff von Information, und um den definieren zu können, ein Modell von Nachrichtenübertragung, in diesem Fall etwa: eine Wahl überträgt die Wünsche zur Organisation der Gesellschaft von Wählenden an die Macht.

Information: Nachrichten in Bits gemessen

Wie viel Information steckt nun in den Wunschlisten dieses Modells? Nun, Information – gemessen in Bit – lässt sich recht anschaulich definieren als die Zahl der ja/nein-Fragen, die mensch bei optimaler Fragestrategie im schlimmsten Fall stellen muss, um einer Menge verschiedener Nachrichten eine ganz bestimmte Nachricht rauszufiltern.

Wenn die Wahl heißt „Parkplätze zu Parks?“ und sonst nichts, reicht eine solche Frage, und mithin wird ein Bit Information übertragen. Kommt als zweite Frage hinzu „Lebkuchen subventionieren?“, braucht es zwei Fragen und mithin Bit, um die kompletten Wünsche zu übertragen.

Wenn mensch das fortführt, ergibt sich: Für ein komplettes Programm mit n binären Entscheidungen braucht es naiv erstmal n bit Information. Diese n bit reichen aus, um 2n Programme zu kodieren, nämlich alle Kombinationen von ja/nein Entscheidungen über die n Fragen hinweg. Wenn es nur die Parkplätze und die Lebkuchen von oben gäbe, wären das beispielsweise:

- für Parkplätze/für Lebkuchen

- für Parkplätze/gegen Lebkuchen

- gegen Parkplätze/für Lebkuchen

- gegen Parkplätze/gegen Lebkuchen

Nochmal: Mit n bits kann ich 2n verschiedene Nachrichten (hier also Programme oder Wunschzettel) auseinanderhalten.

Das kann mensch jetzt rückwärts aufziehen. Um den Informationsgehalt einer Nachricht herauszubekommen, muss mensch sehen, wie viele verschiedene Nachrichten es gibt und diese Zahl dann als 2x darstellen. Das x in diesem Ausdruck ist der Informationsgehalt in Bit. Das x braucht mensch nicht zu raten, denn es ist nichts anderes als der Logarithmus der Zahl der verschiedenen Nachrichten, genauer der Zweierlogarithmus (meist als ld geschrieben). Wenn euer Taschenrechner den nicht kann: ld x = ln x/ln 2 – aber letztlich kommts nicht so drauf an, denn ln 2 ist nicht viel was anderes als eins. Profis schenken sich sowas.

Pop Quiz: Wie viele Bits braucht ihr, um eine von 1000 Nachrichten rauszufummeln? (Ungefähr 10). Wie viele, um eine von 1'000'000'0000 zu kriegen? (Ungefähr 30; ihr seht, der Logarithmus wächst sehr langsam).

Nicht gleichverteilt, nicht unabhängig

In Wahrheit ist das mit der Information etwas komplizierter. Stellt euch vor, zur Parkplatz-Lebkuchen-Programmatik käme jetzt die Frage „Vorrang für FußgängerInnen auf der Straße?“. Wer die Antwort einer Person auf die Parkplatz-Frage kennt, dürfte recht zuverlässig vorhersagen können, wie ihre Antwort auf die Vorrang-Frage aussehen wird.

Mathematisch gesprochen sind die beiden Entscheidungen nicht unabhängig, und das führt dazu, dass mensch durch geschicktes Fragen im Schnitt deutlich weniger als drei Fragen brauchen wird, um das komplette Programm mit den drei Antworten rauszukriegen, etwa, indem mensch zusammen nach Parkplätzen und Vorrang fragt. Dieser Schnitt liegt irgendwo zwischen 2 und 3 – für die Mathematik (und den Logarithmus) ist es kein Problem, Fragen auch hinter dem Komma zu zählen: 2.3 bit, vielleicht (ich bin immer wieder erstaunt, wie viele Menschen noch gewillt sind, Parkplätze hinzunehmen, während der Vorrang für FußgängerInnen doch hoffentlich unbestrittener Konsens in der zivilisierten Welt ist[1]).

Ein ähnlicher Effekt ergibt sich, wenn bestimmte Antworten viel wahrscheinlicher sind als andere. Wenn es z.B. zwei Texte A und B gibt, die jeweils 45% der Nachrichten ausmachen, bekomme ich in 90% der Fälle die Nachricht in nur zwei Fragen raus („Eins von A oder B?“, worauf zu 90% schlicht „A?“ reicht, um die gewählte Nachricht rauszukriegen), ganz egal, ob es noch 10 oder 10'000'000'000 andere Nachrichten gibt.

Die Sache mit „Information in bit rechnest du als den Logarithmus der Zahl der verschiedenen Nachrichten aus“ gibt also eine Obergrenze für den Informationsgehalt. Sie wird erreicht wenn die Nachrichten gleichverteilt sind (und in gewissem Sinn in sich unabhängig; besser verständlich wird der Unabhängigkeits-Teil, wenn mensch nicht eine Nachricht, sondern eine Folge von Nachrichten betrachtet). Wer wissen will, wie das richtig geht, sei auf die Wikipedia verwiesen.

Das ganz einfache Modell unabhängiger, gleichverteilter Nachrichten von oben gilt in der Regel nicht – in natürlichsprachigen Texten sind z.B. die Buchstabenhhäufigkeiten drastisch verschieden (Scrabble-SpielerInnen kennen das), und es gibt allerlei Regeln, in welchen Reihenfolgen Buchstaben kommen können. Eine erstaunlich effektive Schätzung für den Informationsgehalt von Nachrichten ist übrigens, einfach mal gzip laufen zu lassen: Für diesen Text bis hierher kommt da 2090 Bytes (á 8 bit) raus, während er auf der Platte 4394 Bytes braucht: Was gzip da geschluckt hat, sind die Abweichungen von Gleichverteilung und Unabhängigkeit, die so ein dummes Computerprogramm leicht finden kann.

Klar: auch die 2090 ⋅ 8 bit sind höchst fragwürdig als Schätzung für den Informationsgehalt bis hier. Wenn die Nachrichtenmenge „alle bisherigen Blogposts hier“ wäre (davon gibt es etwas weniger als 100), wären es nur sechseinhalb Bit, ist sie „Zeug, das Anselm Flügel schreibt“, wäre es zwar mehr, aber immer noch klar weniger als die 16720 Bit, trotz aller Exkurse über Information und Logarithmen[2]. Informationsgehalt ist nur im Kontext aller anderen möglichen Nachrichten gut definiert. Und dem, was bei EmpfängerInnen ankommt, was bei diesem Post für SchurkInnen auch nur ein Bit sein kann: „Alles Mist“.

Wie viele bit in einem Wahlzettel?

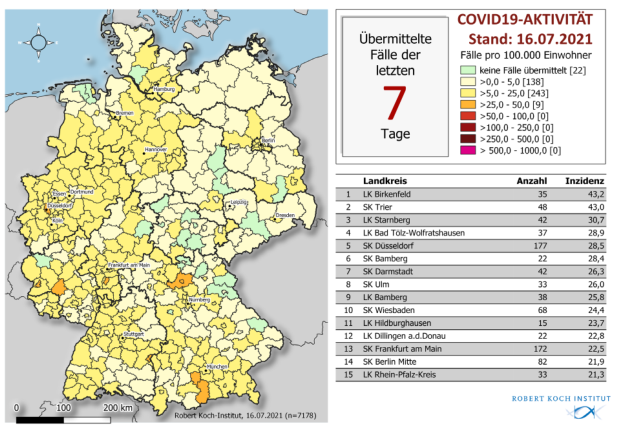

Euer Wahlzettel bei der Bundestagswahl neulich dürfte so um die zwei Mal sechzehn Möglichkeiten gehabt haben, etwas anzukreuzen. Im besten Fall – unabhängige Parteien mit gleichen Erfolgschancen – könntet ihr also 8 bit übertragen mit euren zwei Kreuzen. In Wahrheit sorgt schon die 5%-Hürde dafür, dass es allenfalls 8 Listen gibt, die in der Logik repräsentativer Regierungsbildung wählbar sind, und dann noch vielleicht eineN von vier DirektkandidatInnen, die auch nur irgendeine Chance haben. Zusammen, schätze ich (immer noch optimistisch), vielleicht drei Bit.

Vergleicht das mit den Nachrichten, die so eine Regierung aussendet: So redundant und erwartbar da auch viel sein mag, kein gzip dieser Welt wird die Gesetze, Verordnungen und Exekutivakte von Regierung und Parlament in der letzten Legislaturperiode auf irgendwas unter 100 Megabyte bringen können, selbst wenn es, das Kompressionsprogramm, Politik und Jura schon kann. Gesetze wie das zur Bestandsdatenauskunft etwa sind völlig beliebig: sie setzen einfach Wünsche der Polizeien um und kümmern sich weder um Verfassungen noch um Sinn, und sie würden deutlich anders aussehen, wenn bei BKA, Innenministerium und Polizeiverbänden gerade andere Individuen am Werk gewesen wären. Beliebigkeit ist aber nur ein anderes Wort für Unabhängigkeit und Gleichverteilung. Die 100 Megabyte werden also eine harte untere Grenze sein.

Bei einem Verhältnis von rund drei Bit rein zu mindestens 100 Megabyte raus (in Worten: eins zu zweihunderfünfzig Millionen, weit unter der Gewinnchance beim 6 aus 49-Lotto) ist evident, dass Wahlen gewiss kein „Hochamt der Demokratie“ sind; ihr Einfluss auf konkrete Entscheidungen wäre auch dann minimal, wenn bei realen Wahlen viel entschieden würde.

Was natürlich nicht der Fall ist. Niemand erwartet ernsthaft, dass eine Wahl irgendetwas ändert an wesentlichen Politikfragen, hierzulande beispielsweise Reduzierung des Freihandels, Zurückrollen von Privatisierungen, Abschaffung des Militärs, Befreiung der Menschen von der Autoplage, weniger autoritäres Management sozialer Spannungen (z.B. durch weniger übergriffige Polizeigesetze), weniger blutige Staatsgrenzen, weniger marktförmige Verteilung von Boden, kein Wachstum bis zum Kollaps und so weiter und so fort; praktisch die gesamte Bevölkerung hat in allen diesen Punkten die bestehende Regierungspolitik bestätigt, obwohl sie manifest ihren Interessen oder zumindest ihrem moralischen Empfinden widerspricht.

Warum Wahlen wichtig sind

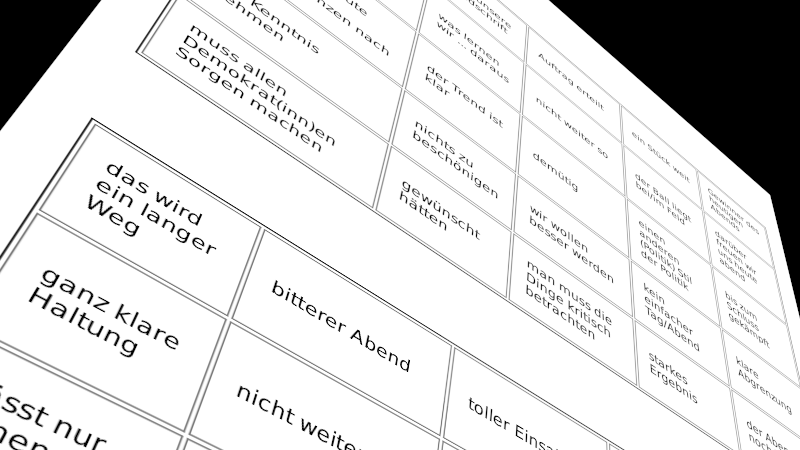

Entsprechend tut in den gegenwärtigen Koalitionsverhandlungen nicht mal wer so, als ginge es um mehr als um Selbstverständlichkeiten wie Tempolimits auf Autobahnen (stellt euch mal kurz vor, wie unfassbar bizarr das auf in 100 Jahren eventuell noch lebende Menschen wirken muss).

Was nicht heißt, dass Wahlen nicht wichtig sind. Die ganz zentrale Funktion von Wahlen dieser Art hat neulich im Deutschlandfunk ein gewisser Andrej Kolesnikow am Beispiel Russland erläutert:

Die Wahl soll vor allem das Staatsmodell legitimieren, das sich in Russland entwickelt hat. Sie ist deshalb für die Staatsmacht wichtiger als für die Bürger. Die Wahl soll den Menschen auch vor Augen führen, dass die Staatsmacht weiterhin über eine Mehrheit verfügt und dass es besser ist, sich dieser Mehrheit anzuschließen, oder, wenn jemand unzufrieden ist, wenigstens ruhig zu bleiben und seine Unzufriedenheit für sich zu behalten.

Wer aus ein paar Schritt Entfernung auf die hiesigen Verhältnisse blickt, wird diese Beobachtung auch hierzulande im Wesentlichen bestätigt sehen. Versteht mich nicht falsch: Das ist durchaus wichtig. Ein delegitimierter Staat geht schnell in eine kaputte Gesellschaft über, solange wir es nicht hinbekommen, Menschen auch ohne Nationalgeklingele zu rationalem, sprich kooperativem Verhalten zu bekommen (nicht, dass ich glaube, dass das sehr schwer wäre; es würde aber jedenfalls andere Schulen brauchen). Etwas von dieser Delegitimation sehen wir schon hier, verglichen mit den 1980er Jahren jedenfalls, etwas mehr in den USA, und noch viel mehr im, sagen wir, Libanon. Und etwas weniger als hier in Dänemark oder Schweden. Ich mache kein Geheimnis daraus, wo auf diesem Spektrum ich lieber leben will.

Allerdings: diese Legitimationsfunktion der Wahl funktioniert weitgehend unabhängig von politischer Partizipation. Auch die finstersten autoritären Regimes halten Wahlen ab und wollen diese in aller Regel auch recht ehrlich …

![[RSS]](./theme/image/rss.png)